La plus grande source d'information au monde se trouve probablement sur Internet. La collecte et l'analyse de données à partir de sites Web ont de vastes applications potentielles dans un large éventail de domaines, notamment la science des données, l'intelligence d'entreprise et les rapports d'investigation.

Les scientifiques des données sont constamment à la recherche de nouvelles informations et données à modifier et à analyser. Gratter Internet pour obtenir des informations spécifiques est actuellement l'une des méthodes les plus populaires pour le faire.

Êtes-vous prêt pour votre première expérience de scraping Web ? Mais d'abord, vous devez comprendre ce qu'est réellement le web scraping et certains de ses principes fondamentaux, puis nous parlerons des meilleures techniques de web scraping.

Qu'est-ce que le Web Scraping?

La technique de collecte et de traitement des données brutes du Web est connue sous le nom de web scraping, et la communauté Python a développé des outils de web scraping assez puissants. UN pipeline de données est utilisé pour traiter et stocker ces données de manière structurée.

Le web scraping est aujourd'hui une pratique courante avec de nombreuses applications :

- Les entreprises de marketing et de vente peuvent collecter des données relatives aux prospects en utilisant le web scraping.

- Les sociétés immobilières peuvent obtenir des informations sur les nouveaux développements, les propriétés à vendre, etc. en utilisant le web scraping.

- Les sites Web de comparaison de prix comme Trivago utilisent fréquemment le grattage Web pour obtenir des données sur les produits et les prix de différents sites Web de commerce électronique.

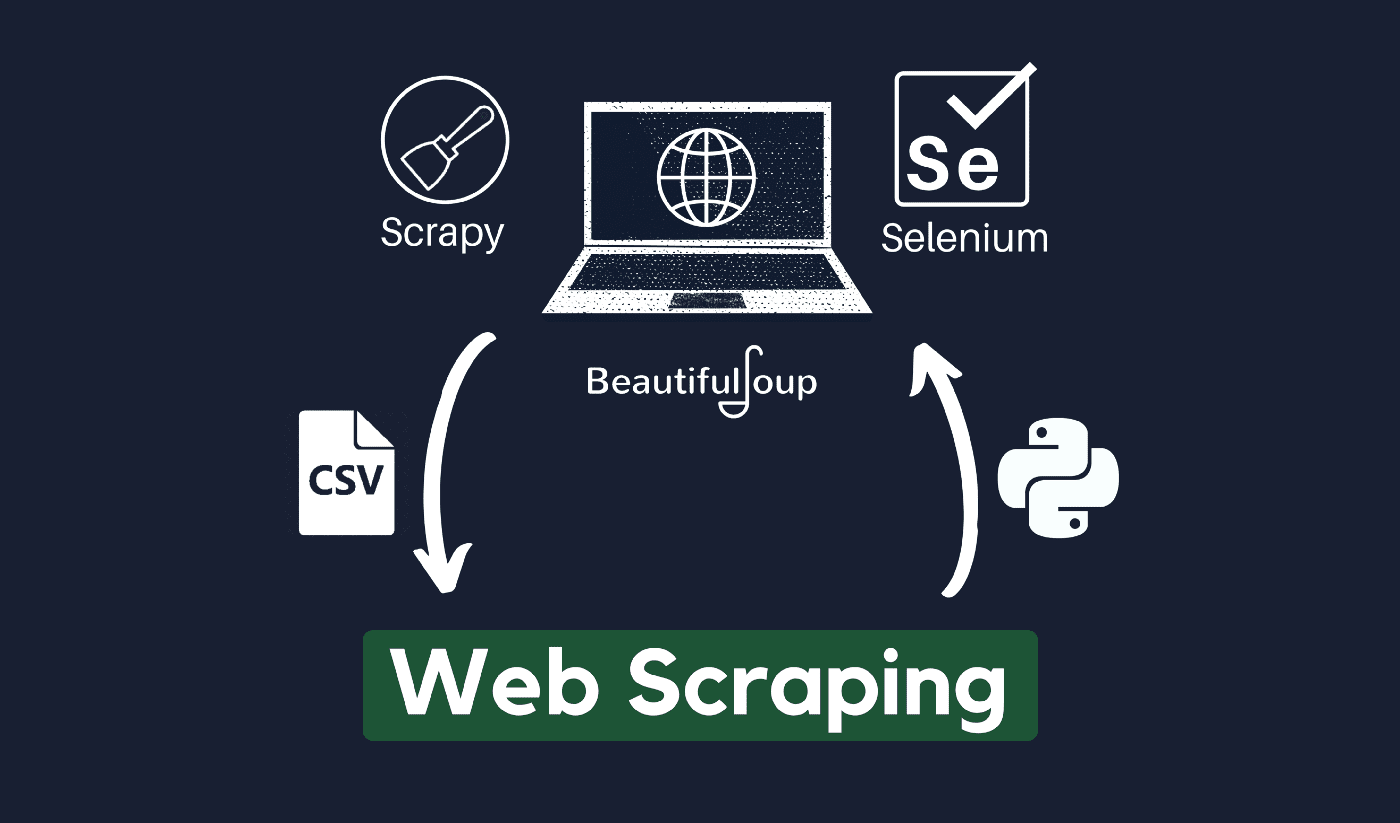

Vous pouvez gratter le Web en utilisant une variété de langages de programmation, et chaque langage de programmation possède une variété de bibliothèques qui peuvent vous aider à accomplir la même chose. L'un des programmes les plus populaires, les plus fiables et les plus légitimes utilisés pour un scraping Web efficace est Python.

À propos de Python

Python est le langage le plus populaire pour le scraping, développé et lancé en 1991. Ce langage de programmation est fréquemment utilisé pour créer des sites Web, écrire du code, créer des logiciels, créer des scripts système, etc. Le programme est une pierre angulaire du secteur en ligne et est largement utilisé dans le commerce à travers le monde.

Les applications Web peuvent être développées sur un serveur à l'aide de Python. Il peut être utilisé conjointement avec des applications pour créer des processus et établir des liens avec des systèmes de base de données. Les fichiers peuvent également être lus et modifiés par celui-ci.

Il peut également être utilisé pour gérer des données volumineuses, effectuer des opérations mathématiques complexes, accélérer le processus de prototype ou créer un logiciel prêt pour la production.

Comment pouvez-vous utiliser Python pour le web scraping ?

Vous devrez probablement passer par trois étapes pour récupérer et extraire toute information d'Internet : obtenir du code HTML, obtenir l'arborescence HTML et enfin extraire les informations de l'arborescence.

Il est possible de récupérer le code HTML d'un site donné à l'aide de la bibliothèque Requests. L'arborescence HTML sera ensuite analysée et extraite à l'aide de BeautifulSoup, et les données peuvent ensuite être organisées en utilisant uniquement Python.

Il est toujours conseillé de vérifier la politique d'utilisation acceptable de votre site Web cible pour voir si l'accès au site Web à l'aide d'outils automatisés est une violation de ses conditions d'utilisation avant d'utiliser vos talents Python pour le grattage Web.

Comment fonctionne le raclage Web?

Les araignées sont généralement utilisées dans le web grattage processus. Ils récupèrent les documents HTML des sites Web pertinents, extraient le contenu nécessaire en fonction de la logique métier, puis le stockent dans un certain format.

Ce site Web sert de guide pour créer des scrappers hautement évolutifs.

Les frameworks et approches Python combinés à quelques extraits de code peuvent être utilisés pour récupérer des données de plusieurs manières simples. Il existe plusieurs guides disponibles qui peuvent vous aider à mettre la même chose en pratique.

Le grattage d'une seule page est simple, mais la gestion du code d'araignée, la collecte de données et la maintenance d'un entrepôt de données sont difficiles lors du grattage de millions de pages. Pour rendre le grattage simple et précis, nous allons examiner ces problèmes et leurs correctifs.

Liens rapides:

**Astuce supplémentaire : utilisez des IP et des services proxy rotatifs

Comme vous l'avez clairement compris, le scraping Web vous permet de collecter des informations sur le Web à l'aide d'un ensemble de commandes de programmation. Mais comme vous devez le savoir, vos activités de grattage Web peuvent être tracées via votre adresse IP.

Ce ne sera pas vraiment un problème si les données que vous extrayez d'un domaine public. Mais si vous extrayez des données privées d'un site de média spécial, par exemple, vous risquez d'avoir des ennuis si votre adresse IP est retrouvée.

Donc, en gros, pour éviter que votre spider ne soit blacklisté, il est toujours préférable d'utiliser des services proxy et de changer les adresses IP.

Nous ne vous encourageons en aucun cas à utiliser le web scraping pour collecter des données illégales ou privées, ou à vous livrer à des activités de logiciels espions malveillants ?

Mais si vous collectez des données qui pourraient être privées, il est recommandé de masquer ou de faire pivoter votre adresse IP ou utilisez un serveur proxy pour éviter d'être tracé.

Vous pouvez également lire:

Le web scraping est-il légal ?

Officiellement, il n'est nulle part indiqué dans les normes et directives Internet que le scraping Web est illégal. En toute honnêteté, le scraping Web est totalement légal, à condition que vous travailliez sur des données publiques.

Fin janvier 2020, il a été annoncé que le grattage des données accessibles au public à des fins non commerciales était entièrement autorisé.

Les informations librement accessibles au grand public sont des données accessibles à tous en ligne sans mot de passe ni autre authentification. Ainsi, les informations accessibles au public incluent celles qui peuvent être trouvées sur Wikipédia, les réseaux sociaux ou Recherche Google résultats.

Cependant, certains sites Web interdisent explicitement aux utilisateurs de gratter leurs données avec le web scraping. Récupérer des données sur les réseaux sociaux est parfois considéré comme illégal.

La raison en est que certaines d'entre elles ne sont pas accessibles au grand public, par exemple lorsqu'un utilisateur rend ses informations privées. Dans ce cas, le scraping de ces informations est interdit. Le grattage d'informations sur des sites Web sans le consentement du propriétaire peut également être considéré comme nuisible.

Tirez le meilleur parti du Web grâce au Web Scraping !

La collecte et l'analyse de données à partir de sites Web ont de vastes applications potentielles dans un large éventail de domaines, notamment la science des données, l'intelligence d'entreprise et les rapports d'investigation.

L'une des capacités fondamentales dont un data scientist a besoin est le web scraping.

Gardez à l'esprit que tout le monde ne voudra pas que vous accédiez à ses serveurs Web pour obtenir des données. Avant de commencer à gratter un site Web, assurez-vous d'avoir lu les conditions d'utilisation. Soyez également attentif lorsque vous chronométrez vos requêtes Web pour éviter de surcharger un serveur.

Liens directs