Nguồn thông tin lớn nhất thế giới có thể được tìm thấy trên Internet. Thu thập và phân tích dữ liệu từ các trang web có các ứng dụng tiềm năng rộng lớn trong nhiều lĩnh vực, bao gồm khoa học dữ liệu, trí tuệ doanh nghiệp và báo cáo điều tra.

Các nhà khoa học dữ liệu không ngừng tìm kiếm thông tin và dữ liệu mới để sửa đổi và phân tích. Tìm kiếm thông tin cụ thể trên internet hiện là một trong những phương pháp phổ biến nhất để làm như vậy.

Bạn đã chuẩn bị cho trải nghiệm quét web đầu tiên của mình chưa? Nhưng trước tiên, bạn phải hiểu web scraping thực sự là gì và một số nguyên tắc cơ bản của nó, sau đó chúng ta sẽ nói về các kỹ thuật cạo web tốt nhất.

Web Scraping là gì?

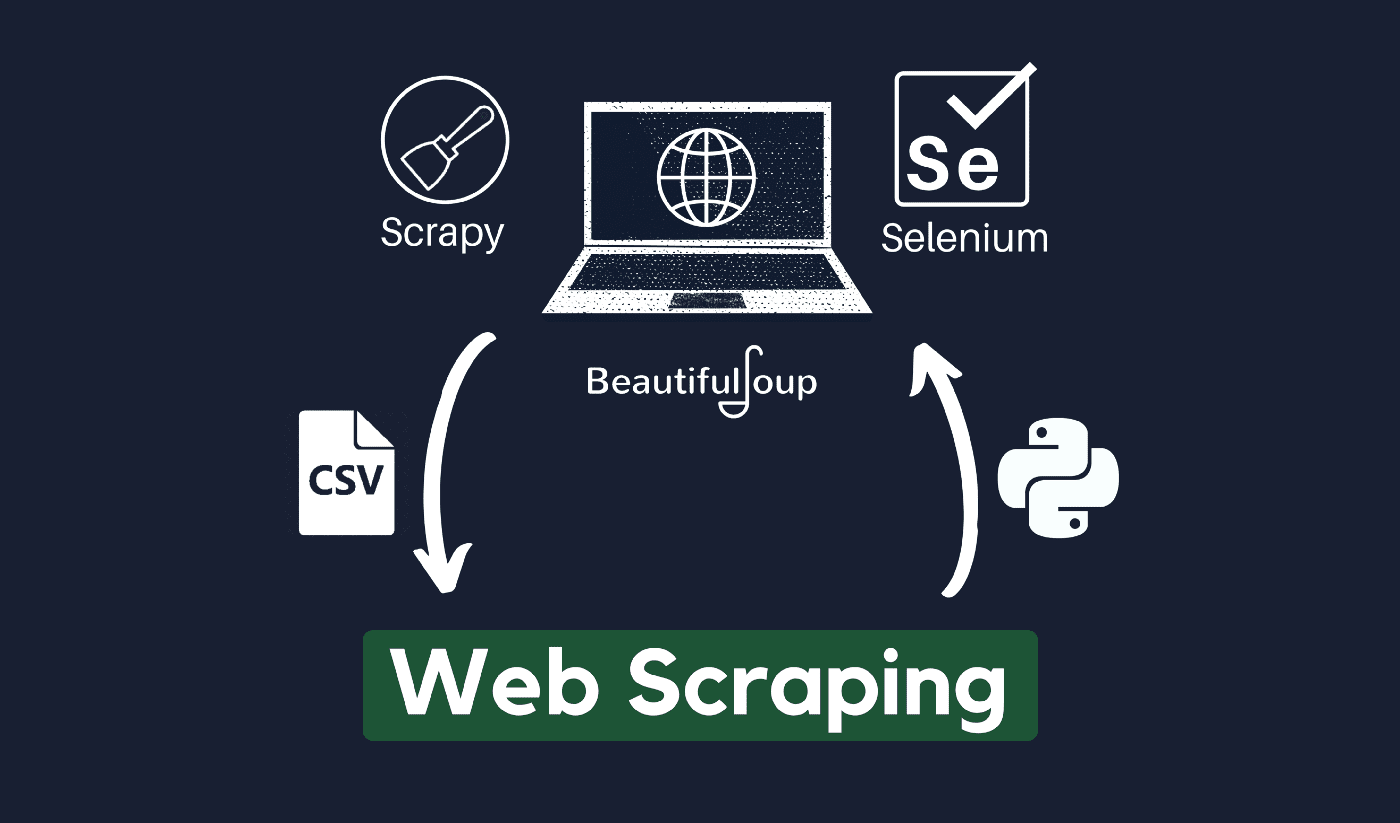

Kỹ thuật thu thập và xử lý dữ liệu thô từ Web được gọi là quét web và cộng đồng Python đã phát triển một số công cụ quét web khá hiệu quả. MỘT đường dẫn dữ liệu được sử dụng để xử lý và lưu trữ dữ liệu này theo cách có cấu trúc.

Quét web là một thực tế phổ biến ngày nay với nhiều ứng dụng:

- Các doanh nghiệp tiếp thị và bán hàng có thể thu thập dữ liệu liên quan đến khách hàng tiềm năng bằng cách sử dụng tính năng quét web.

- Các công ty bất động sản có thể lấy thông tin về các dự án phát triển mới, tài sản rao bán, v.v. bằng cách sử dụng tính năng tìm kiếm trên web.

- Các trang web so sánh giá như Trivago thường sử dụng tính năng quét web để lấy dữ liệu về sản phẩm và giá cả từ các trang web thương mại điện tử khác nhau.

Bạn có thể quét web bằng nhiều loại ngôn ngữ lập trìnhvà mỗi ngôn ngữ lập trình có nhiều thư viện có thể giúp bạn thực hiện điều tương tự. Một trong những chương trình phổ biến, đáng tin cậy và hợp pháp nhất được sử dụng để quét web hiệu quả là Python.

Về Python

Python là ngôn ngữ phổ biến nhất để cạo được phát triển và ra mắt vào năm 1991. Ngôn ngữ lập trình này thường được sử dụng để tạo trang web, viết mã, tạo phần mềm, tạo tập lệnh hệ thống và những thứ khác. Chương trình này là nền tảng của lĩnh vực trực tuyến và được sử dụng rộng rãi trong thương mại trên toàn thế giới.

Các ứng dụng web có thể được phát triển trên máy chủ bằng Python. Nó có thể được sử dụng kết hợp với các ứng dụng để xây dựng quy trình và liên kết với hệ thống cơ sở dữ liệu. Các tập tin cũng có thể được đọc và thay đổi bởi nó.

Nó cũng có thể được sử dụng để quản lý dữ liệu lớn, thực hiện các phép toán phức tạp, tăng tốc quy trình nguyên mẫu hoặc tạo phần mềm sẵn sàng để sản xuất.

Bạn có thể sử dụng Python để quét web như thế nào?

Có thể bạn sẽ cần trải qua ba bước để thu thập và trích xuất bất kỳ thông tin nào từ internet: lấy HTML, lấy cây HTML và cuối cùng là trích xuất thông tin từ cây.

Có thể truy xuất mã HTML từ một Trang web nhất định bằng thư viện Yêu cầu. Cây HTML sau đó sẽ được phân tích cú pháp và trích xuất bằng cách sử dụng ĐẹpSúpvà dữ liệu sau đó có thể được sắp xếp chỉ bằng Python.

Bạn luôn nên kiểm tra chính sách sử dụng được chấp nhận của trang web mục tiêu của mình để xem liệu việc truy cập trang web bằng các công cụ tự động có vi phạm các điều kiện sử dụng hay không trước khi sử dụng tài năng Python của bạn để quét web.

Quét web hoạt động như thế nào?

Nhện thường được sử dụng trong mạng cào quá trình. Chúng truy xuất các tài liệu HTML từ các trang web có liên quan, trích xuất nội dung cần thiết dựa trên logic nghiệp vụ và sau đó lưu trữ nội dung đó ở một định dạng nhất định.

Trang web này phục vụ như một hướng dẫn để tạo các trình dọn dẹp có khả năng mở rộng cao.

Các phương pháp và khuôn khổ Python kết hợp với một vài đoạn mã có thể được sử dụng để thu thập dữ liệu theo một số cách đơn giản. Có một số hướng dẫn có sẵn có thể giúp bạn áp dụng điều tương tự vào thực tế.

Việc cạo một trang đơn lẻ rất đơn giản, nhưng việc quản lý mã nhện, thu thập dữ liệu và bảo trì kho dữ liệu rất khó khăn khi cạo hàng triệu trang. Để làm cho việc cạo đơn giản và chính xác, chúng ta sẽ xem xét các sự cố này và cách khắc phục chúng.

Đường dẫn nhanh:

**Mẹo bổ sung: Sử dụng IP luân phiên và Dịch vụ proxy

Như bạn đã hiểu rõ, việc quét web cho phép bạn thu thập thông tin từ web bằng cách sử dụng một tập hợp các lệnh lập trình. Nhưng như bạn phải biết, các hoạt động quét web của bạn có thể được theo dõi thông qua địa chỉ IP của bạn.

Đây sẽ không phải là vấn đề lớn nếu dữ liệu bạn đang thu thập từ miền công cộng. Nhưng nếu bạn đang thu thập dữ liệu riêng tư từ một trang web truyền thông đặc biệt, thì bạn có thể gặp rắc rối nếu địa chỉ IP của bạn bị theo dõi.

Vì vậy, về cơ bản, để ngăn con nhện của bạn bị đưa vào danh sách đen, bạn nên sử dụng các dịch vụ proxy và thay đổi địa chỉ IP.

Không có nghĩa là chúng tôi khuyến khích bạn sử dụng tính năng quét web để thu thập bất kỳ dữ liệu riêng tư hoặc bất hợp pháp nào hoặc tham gia vào một số hoạt động phần mềm gián điệp độc hại?

Nhưng nếu bạn đang thu thập dữ liệu có thể là riêng tư, bạn nên ẩn hoặc xoay Địa chỉ IP hoặc sử dụng máy chủ proxy để tránh bị theo dõi.

Bạn cũng có thể thích đọc:

Quét web có hợp pháp không?

Chính thức, không có nơi nào nêu trong các quy tắc và hướng dẫn trên internet rằng việc quét web là bất hợp pháp. Công bằng mà nói, việc quét web là hoàn toàn hợp pháp, miễn là bạn đang làm việc trên dữ liệu công khai.

Vào cuối tháng 2020 năm XNUMX, có thông báo rằng việc thu thập dữ liệu có sẵn công khai cho các mục đích phi thương mại là hoàn toàn được cho phép.

Thông tin mà công chúng có thể truy cập miễn phí là dữ liệu mà mọi người có thể truy cập trực tuyến mà không cần mật khẩu hoặc xác thực khác. Vì vậy, thông tin có sẵn công khai bao gồm thông tin có thể tìm thấy trên Wikipedia, phương tiện truyền thông xã hội hoặc Tìm kiếm Google kết quả.

Tuy nhiên, một số trang web rõ ràng cấm người dùng cạo dữ liệu của họ bằng cách quét web. Cạo dữ liệu từ phương tiện truyền thông xã hội đôi khi được coi là bất hợp pháp.

Lý do cho điều này là một số trong số đó không thể truy cập được đối với công chúng, chẳng hạn như khi người dùng đặt thông tin của họ ở chế độ riêng tư. Trong trường hợp này, việc cạo thông tin này bị cấm. Cạo thông tin từ các trang web mà không có sự đồng ý của chủ sở hữu cũng có thể được coi là có hại.

Khai thác tốt nhất trang web thông qua Web Scraping!

Thu thập và phân tích dữ liệu từ các trang web có các ứng dụng tiềm năng rộng lớn trong nhiều lĩnh vực, bao gồm khoa học dữ liệu, trí tuệ doanh nghiệp và báo cáo điều tra.

Một trong những khả năng cơ bản mà một nhà khoa học dữ liệu yêu cầu là quét web.

Hãy nhớ rằng không phải ai cũng muốn bạn truy cập máy chủ web của họ để lấy dữ liệu. Trước khi bắt đầu tìm kiếm một trang web, hãy đảm bảo rằng bạn đã đọc Điều kiện sử dụng. Ngoài ra, hãy cân nhắc khi định thời gian cho các truy vấn web của bạn để tránh làm quá tải máy chủ.

Liên kết nhanh