世界上最大的信息来源可能是在 Internet 上找到的。 从网站收集和分析数据在广泛的领域具有巨大的潜在应用,包括数据科学、企业情报和调查报告。

数据科学家不断寻找新的信息和数据进行修改和分析。 从互联网上抓取特定信息是目前最流行的方法之一。

您准备好迎接第一次网络抓取体验了吗? 但首先,您必须了解什么是网络抓取及其一些基本原理,然后我们将讨论最好的网络抓取技术。

什么是网页抓取?

从 Web 收集和处理原始数据的技术称为网络抓取,Python 社区开发了一些相当强大的网络抓取工具。 A 数据管道 用于以结构化方式处理和存储此数据。

Web 抓取是当今许多应用程序的常见做法:

- 营销和销售业务可以使用网络抓取来收集与潜在客户相关的数据。

- 房地产公司可以通过网络抓取获取有关新开发项目、待售物业等的信息。

- 像 Trivago 这样的价格比较网站经常使用网络抓取来从不同的电子商务网站获取产品和定价数据。

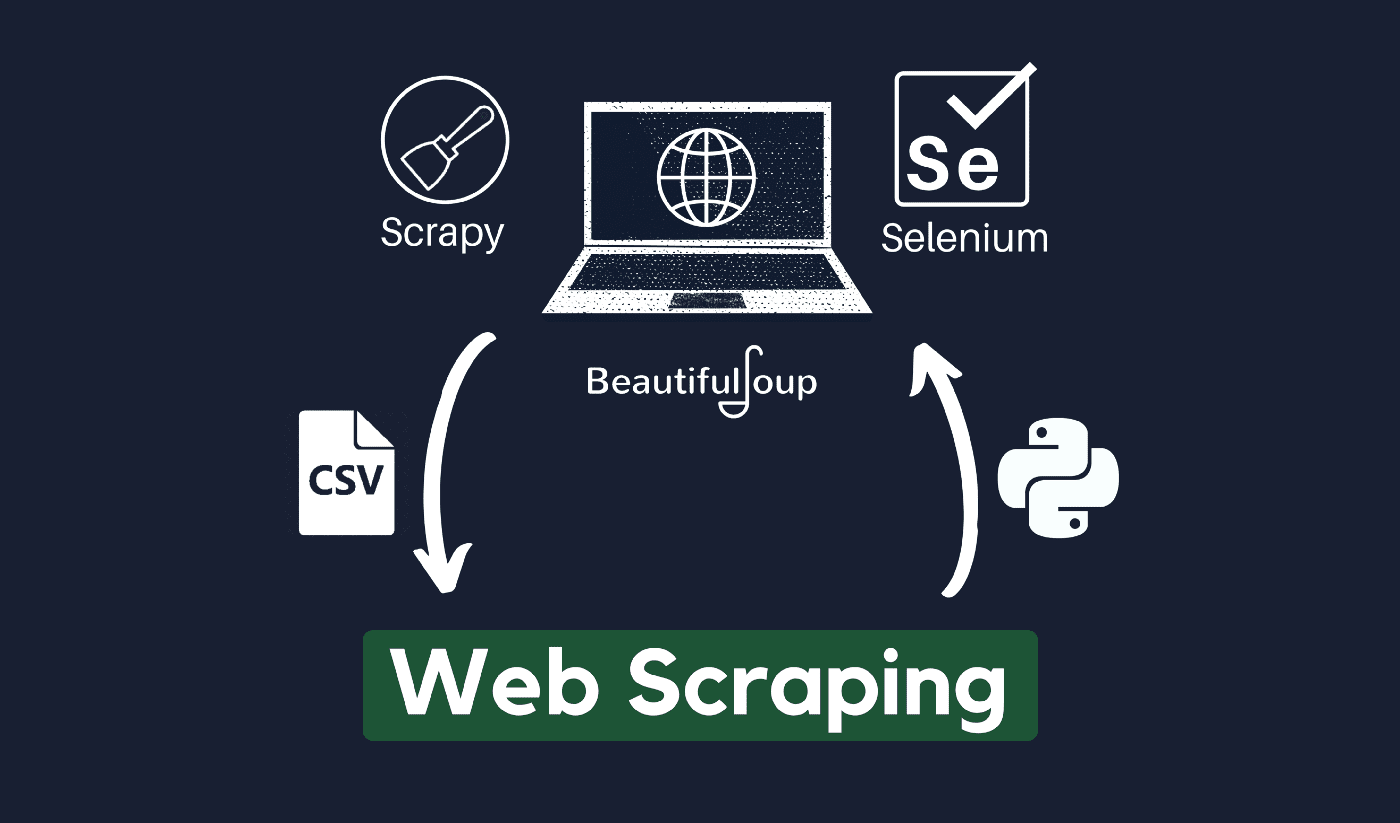

您可以使用各种方式抓取网页 编程语言,并且每种编程语言都有各种库可以帮助您完成同一件事。 用于有效网络抓取的最流行、最受信任和合法的程序之一是 Python。

关于 Python

Python 是 1991 年开发和推出的最流行的抓取语言。这种编程语言经常用于创建网站、编写代码、创建软件、创建系统脚本等。 该程序是在线行业的基石,广泛用于世界各地的商业活动。

可以使用 Python 在服务器上开发 Web 应用程序。 它可以与应用程序结合使用以构建流程并链接到数据库系统。 它也可以读取和更改文件。

它还可用于管理海量数据、执行复杂的数学运算、加快原型制作过程或创建可用于生产的软件。

如何使用 Python 进行网页抓取?

您可能需要经历三个步骤才能从 Internet 上抓取和提取任何信息:获取 HTML、获取 HTML 树以及最后从树中提取信息。

可以使用 Requests 库从给定站点检索 HTML 代码。 然后将使用以下方法解析和提取 HTML 树 美丽汤,然后可以仅使用 Python 来组织数据。

在使用 Python 人才进行网络抓取之前,始终建议检查目标网站的可接受使用政策,以查看使用自动化工具访问网站是否违反其使用条件。

网页抓取如何工作?

蜘蛛通常用于在线 刮 过程。 他们从相关网站检索HTML文档,根据业务逻辑提取必要的内容,然后以一定的格式存储。

该网站可作为创建高度可扩展的 scraper 的指南。

Python 框架和方法与一些代码片段相结合,可用于以多种直接方式抓取数据。 有几个可用的指南可以帮助您将其付诸实践。

抓取单个页面很简单,但抓取数百万个页面时,管理爬虫代码、收集数据和维护数据仓库就很困难了。 为了使抓取变得简单和精确,我们将检查这些问题及其修复方法。

快速链接:

**附加提示:使用旋转 IP 和代理服务

如您所见,网络抓取允许您使用一组编程命令从网络上收集信息。 但您必须知道,您的网络抓取活动可以通过您的 IP 地址进行追踪。

如果您从公共领域抓取数据,这将不是什么大问题。 但是,如果您从一个特殊的媒体站点抓取私人数据,那么如果您的 IP 地址被追踪到,您可能会遇到麻烦。

所以,基本上,为了防止您的蜘蛛被列入黑名单,最好使用代理服务并更改 IP 地址。

我们绝不鼓励您使用网络抓取来收集任何非法或私人数据,或沉迷于某些恶意间谍软件活动?

但是,如果您正在收集可能是私人的数据,建议屏蔽或旋转您的 IP地址 或使用代理服务器以避免被追踪。

您也可以阅读:

网络抓取合法吗?

正式地,互联网规范和指南中没有任何地方表明网络抓取是非法的。 平心而论,如果您处理的是公共数据,网络抓取是完全合法的。

2020 年 XNUMX 月下旬,宣布完全允许为非商业目的抓取公开数据。

公众可以自由访问的信息是指每个人都可以在线访问的数据,无需密码或其他身份验证。 因此,公开可用的信息包括可以在维基百科、社交媒体或 谷歌搜索 结果。

然而,一些网站明确禁止用户通过网络抓取来抓取他们的数据。 从社交媒体上抓取数据有时被认为是非法的。

这样做的原因是其中一些信息是公众无法访问的,例如当用户将他们的信息设为私有时。 在这种情况下,禁止抓取此信息。 未经所有者同意从网站上抓取信息也被认为是有害的。

通过 Web Scraping 充分利用网络!

从网站收集和分析数据在广泛的领域具有巨大的潜在应用,包括数据科学、企业情报和调查报告。

数据科学家需要的基本能力之一是网络抓取。

请记住,并不是每个人都希望您访问他们的网络服务器以获取数据。 在开始抓取网站之前,请确保您已阅读使用条件。 此外,在安排 Web 查询的时间时要考虑周到,以免服务器不堪重负。

快速链接