온라인 스크래핑을 사용하면 가격 비교, 시장 조사, 광고 확인 등의 목적으로 웹사이트에서 공개 데이터를 수집할 수 있습니다.

일반적으로 대량의 필수 공개 데이터가 추출되지만, 봉쇄에 맞서 실행하면 추출이 어려워질 수 있습니다.

제한은 속도 차단 또는 IP 차단일 수 있습니다(요청의 IP 주소는 금지된 지역, 금지된 IP 유형 등에서 발생하므로 제한됨). (IP 주소는 여러 번 요청했기 때문에 차단되었습니다.)

이제 유용한 지식과 정보를 스크랩하고 싶다면 수많은 정보가 담긴 지식 백과사전인 Wikipedia를 스크랩하는 것을 고려해 보셨을 것입니다.

웹 스크래핑 Wikipedia에 대한 몇 가지 사항을 이해해 보겠습니다.

위키피디아 웹 스크래핑

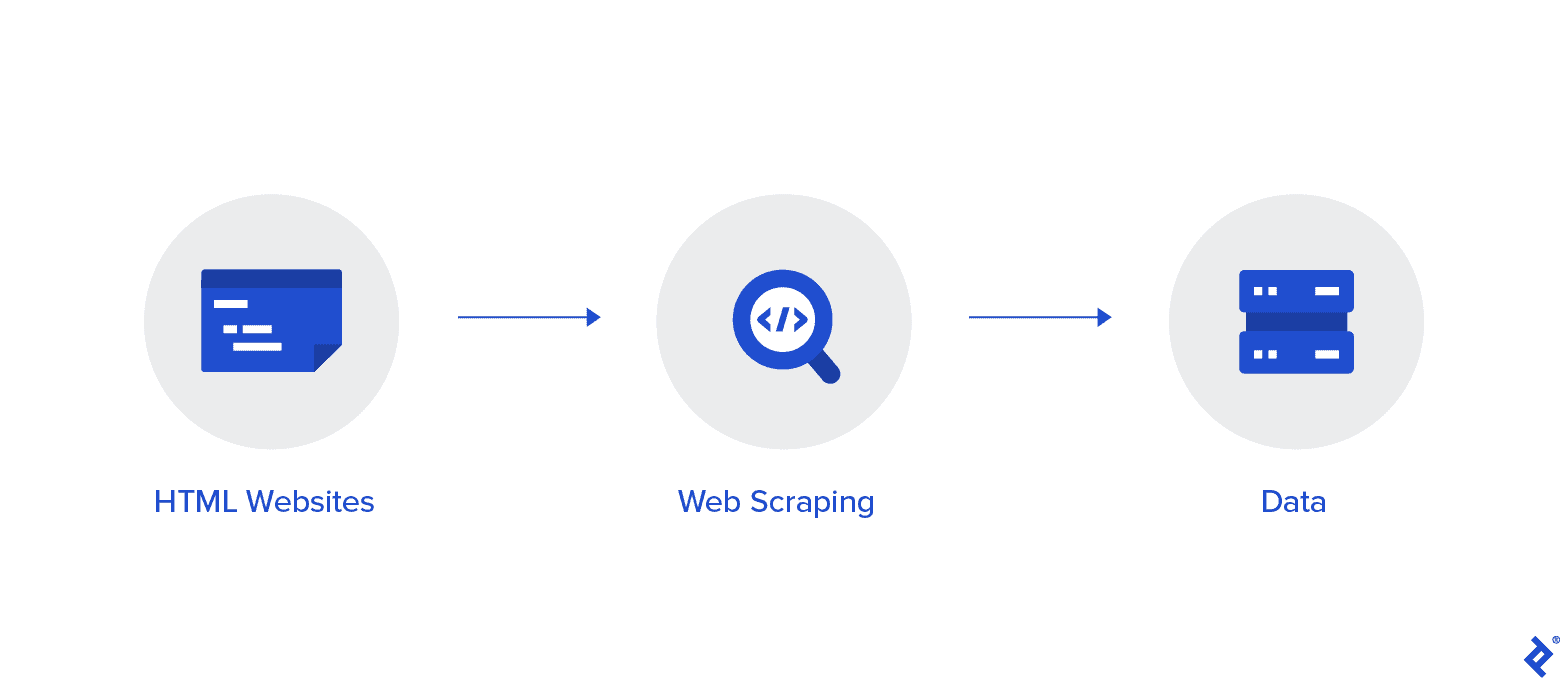

웹 스크래핑은 인터넷에서 데이터를 자동으로 수집하는 방법입니다. 이 기사에서는 웹 스크래핑에 대한 심층적인 정보, 웹 크롤링과의 비교, 웹 스크래핑을 지지하는 주장을 제공합니다.

목표는 다양한 웹 스크래핑 방법을 사용하여 Wikipedia 홈 페이지에서 데이터를 수집한 다음 구문 분석하는 것입니다.

다양한 웹 스크래핑 방법, Python 웹 스크래핑 라이브러리, 데이터 추출 및 처리 절차에 더 익숙해질 것입니다.

웹 스크래핑과 Python

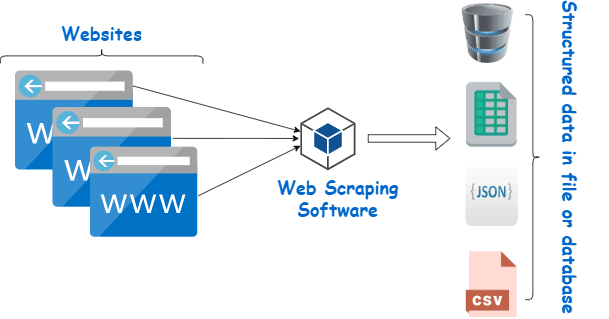

웹 스크래핑은 본질적으로 프로그래밍 언어로 작성된 소프트웨어를 사용하여 수많은 웹사이트의 대량 데이터에서 구조화된 데이터를 추출하고 이를 장치에 로컬로 저장하는 프로세스입니다. 가급적이면 Excel 시트, JSON 또는 스프레드시트에 저장하는 것이 좋습니다.

이는 프로그래머가 크고 작은 프로젝트 모두에 대해 논리적이고 이해하기 쉬운 코드를 작성하는 데 도움이 됩니다.

Python은 주로 웹 스크래핑에 가장 적합한 언어로 간주됩니다. 대부분의 웹 크롤링 관련 작업을 효과적으로 처리할 수 있으며 다재다능합니다.

Wikipedia에서 데이터를 긁어내는 방법은 무엇입니까?

다양한 방법으로 웹 페이지에서 데이터를 추출할 수 있습니다.

예를 들어 다음을 사용하여 직접 구현할 수 있습니다. 컴퓨터 언어 파이썬처럼. 그러나 기술에 능숙하지 않은 경우 이 프로세스를 통해 많은 작업을 수행하려면 먼저 많은 공부를 해야 합니다.

또한 시간이 많이 걸리며 Wikipedia 페이지를 수동으로 샅샅이 뒤지는 것만큼 오랜 시간이 걸릴 수도 있습니다. 또한 무료 웹 스크레이퍼는 온라인으로 액세스할 수 있습니다. 그러나 신뢰성이 부족한 경우가 많으며 공급업체가 음흉한 의도를 갖고 있을 수도 있습니다.

평판이 좋은 공급업체의 괜찮은 웹 스크레이퍼에 투자하는 것이 Wiki 데이터를 수집하는 가장 좋은 방법입니다.

공급자가 스크레이퍼 설치 및 활용 방법에 대한 지침을 제공하므로 다음 단계는 일반적으로 간단하고 복잡하지 않습니다.

프록시는 위키 스크래퍼와 함께 사용하여 데이터를 더 효과적으로 긁어낼 수 있는 도구입니다. Scrapy와 같은 Python 기반 프레임워크, 스크래핑 로봇, Beautiful Soup은 이 언어를 사용하여 스크래핑하는 것이 얼마나 쉬운지를 보여주는 몇 가지 예일 뿐입니다.

Wikipedia의 스크랩 데이터에 대한 프록시

데이터를 효과적으로 긁어내기 위해서는 매우 빠르고 사용하기 안전하며 필요할 때 다운되지 않도록 보장되는 프록시가 필요합니다. 이러한 프록시는 Rayobyte에서 합리적인 가격으로 제공됩니다.

우리는 모든 사용자가 서로 다른 선호도와 사용 사례를 가지고 있다는 것을 알고 있기 때문에 다양한 프록시를 제공하기 위해 노력하고 있습니다.

웹 스크래핑을 위한 회전 프록시 Wikipedia

프록시 인스턴스는 정기적으로 IP 주소를 교체하는 인스턴스입니다. 또한 중단을 방지하기 위해 차단이 발생하면 IP 주소가 즉시 변경됩니다. 따라서 이 특정 프록시는 사이트 스크래핑에 탁월한 선택이 됩니다.

이에 비해 정적 프록시에는 IP 주소가 하나만 있습니다. ISP가 자동 교체를 활성화하지 않는 경우 하나의 IP 주소에만 액세스할 수 있고 차단되면 벽돌 벽에 직면하게 됩니다. 이 때문에 정적 프록시는 웹 스크래핑에 가장 적합한 옵션이 아닙니다.

웹 스크래핑 Wiki 데이터를 위한 주거용 프록시

주거용 프록시는 ISP(인터넷 서비스 제공업체)가 배포하고 특정 가구와 연결되는 프록시 IP 주소입니다. 그것들은 실제 사람들에게서 나왔기 때문에 그것들을 얻는 것은 꽤 어렵습니다. 결과적으로, 그것들은 희소하고 상대적으로 비쌉니다.

주거용 프록시를 사용하여 데이터를 스크랩하면 실제 개인의 주소와 연결되어 있기 때문에 일상적인 사용자처럼 보입니다.

따라서 주거용 프록시를 사용하면 발각되거나 차단될 가능성이 크게 줄어듭니다. 따라서 이들은 데이터 스크래핑에 탁월한 후보입니다.

위키 데이터 수집을 위한 순환 주거용 프록시

방금 말한 두 가지 유형을 결합한 순환 주거용 프록시는 Wikipedia 웹 스크래핑을 위한 최고의 프록시입니다.

자주 교체되는 프록시를 사용하면 다수의 홈 IP에 액세스할 수 있습니다.

주거용 프록시를 식별하는 데 어려움이 있음에도 불구하고 이들이 생성하는 요청량이 결국 웹사이트의 관심을 끌게 되므로 이는 매우 중요합니다.

순환을 통해 IP 주소가 불가피하게 블랙리스트에 등록되더라도 프로젝트를 계속 진행할 수 있습니다.

따라서 우리는 여러 데이터 센터 프록시를 사용하기로 결정했거나 몇 개의 주거용 프록시에 투자하기를 원하든 관계없이 필요한 것을 갖추고 있습니다.

1GBS 속도로 실행되는 프록시, 무제한 대역폭 및 XNUMX시간 고객 지원을 통해 최고의 웹 스크래핑 경험을 누릴 수 있습니다.

너는 또한 읽을지도 모른다

- 최고의 웹 스크래핑 기술: 실용 가이드

- Octoparse Review 정말 좋은 웹 스크래핑 도구인가요?

- 최고의 웹 스크래핑 도구

- 웹 스크래핑이란 무엇입니까?- 어떻게 사용됩니까? 귀하의 비즈니스에 어떻게 도움이 될 수 있습니까?

왜 Wikipedia를 긁어내야 합니까?

Wikipedia는 현재 온라인 세계에서 가장 신뢰할 수 있고 정보가 풍부한 서비스 중 하나입니다. 이 플랫폼에는 생각할 수 있는 거의 모든 종류의 주제에 대한 답변과 정보가 있습니다.

따라서 당연히 Wikipedia는 데이터를 스크랩할 수 있는 훌륭한 소스입니다. Wikipedia를 스크랩해야 하는 주요 이유에 대해 논의해 보겠습니다.

학술 연구를 위한 웹 스크래핑

데이터 수집은 연구와 관련된 가장 고통스러운 활동 중 하나입니다. 이미 논의한 바와 같이 웹 스크레이퍼를 사용하면 이 절차를 더 빠르고 쉽게 만들 수 있을 뿐만 아니라 많은 시간과 에너지를 절약할 수 있습니다.

웹 스크레이퍼를 사용하면 수많은 위키 페이지를 빠르게 스캔하고 필요한 모든 데이터를 체계적으로 수집할 수 있습니다.

우울증과 햇빛 노출이 국가마다 다른지 여부를 확인하는 것이 목표라고 잠시 가정해 보겠습니다.

수많은 Wikipedia 항목을 살펴보는 대신 Wiki 스크레이퍼를 사용하여 여러 국가의 우울증 유병률 및 맑은 시간과 같은 정보를 찾을 수 있습니다.

평판 관리

Wikipedia 게시물이 Google의 첫 번째 페이지에 자주 나타나기 때문에 Wikipedia 페이지를 만드는 것은 현대 시대의 다양한 유형의 비즈니스에서 꼭 해야 할 마케팅 전략이 되었습니다.

하지만 Wikipedia에 페이지를 올리는 것으로 마케팅 활동이 끝나서는 안 됩니다. 위키피디아는 크라우드 소싱 플랫폼, 따라서 기물 파손은 꽤 자주 발생하는 일입니다.

결과적으로 누군가가 귀하 회사 페이지에 불리한 정보를 추가하여 귀하의 평판을 해칠 수 있습니다. 또는 관련 위키 기사에서 귀하의 비즈니스에 명예를 훼손할 수도 있습니다.

이 때문에 Wiki 페이지뿐만 아니라 일단 만들어진 후에는 귀하의 비즈니스를 언급하는 다른 페이지를 계속 주시해야 합니다. 위키 스크레이퍼(wiki scraper)를 사용하면 쉽게 이 작업을 수행할 수 있습니다.

정기적으로 Wikipedia 페이지를 검색하여 귀하의 비즈니스에 대한 참조를 찾아 거기에 있는 기물 파손 사례를 지적할 수 있습니다.

부스트 SEO

Wikipedia를 활용하여 웹사이트 트래픽을 늘릴 수 있습니다.

Wiki 데이터 스크레이퍼를 사용하여 귀하의 비즈니스 및 대상 고객과 관련된 페이지를 찾아서 변경하고 싶은 기사 목록을 만드십시오.

먼저 기사를 읽고 몇 가지 유용한 조정을 수행하여 사이트 기여자로서 신뢰를 얻으세요.

어느 정도 신뢰성을 확보한 후에는 링크가 끊어졌거나 인용이 필요한 위치에 웹사이트에 대한 연결을 추가할 수 있습니다.

빠른 링크

웹 스크래핑에 사용되는 Python 라이브러리

Python은 이미 말했듯이 세계에서 가장 인기 있고 평판이 좋은 프로그래밍 언어이자 웹 스크래핑 도구입니다. 이제 현재 사용 가능한 Python 웹 스크래핑 라이브러리를 살펴보겠습니다.

웹 스크래핑을 위한 요청(인간용 HTTP) 라이브러리

GET 및 POST와 같은 다양한 HTTP 요청을 보내는 데 사용됩니다. 모든 라이브러리 중에서 가장 기본이면서도 가장 중요한 라이브러리입니다.

웹 스크래핑을 위한 lxml 라이브러리

lxml 패키지는 웹사이트의 HTML 및 XML 텍스트를 매우 빠르고 고성능으로 구문 분석하는 기능을 제공합니다. 거대한 데이터베이스를 긁어내려는 경우 선택할 수 있는 것입니다.

웹 스크래핑을 위한 아름다운 수프 라이브러리

그 작업은 콘텐츠 구문 분석을 위한 구문 분석 트리를 구축하는 것입니다. 초보자가 시작하기 좋은 곳이며 사용자 친화적입니다.

웹 스크래핑을 위한 Selenium 라이브러리

이 라이브러리는 위에서 언급한 모든 라이브러리가 가지고 있는 문제, 즉 동적으로 채워진 웹 페이지에서 콘텐츠를 스크랩하는 문제를 해결합니다.

원래는 웹 애플리케이션의 자동화된 테스트를 위해 설계되었습니다. 이로 인해 속도가 느리고 산업 수준의 작업에 적합하지 않습니다.

웹 스크래핑을 위한 Scrapy

완벽한 웹 스크래핑 프레임워크 비동기식 사용을 사용합니다 모든 패키지의 BOSS입니다. 이를 통해 효율성이 향상되고 속도가 엄청나게 빨라집니다.

결론

따라서 이것은 Wikipedia 웹 스크래핑에 대해 알아야 할 가장 중요한 측면이었습니다. 웹 스크래핑 등에 대한 더 많은 유익한 게시물을 보려면 계속 지켜봐 주시기 바랍니다!

한눈에 보기