Największym źródłem informacji na świecie jest prawdopodobnie Internet. Zbieranie i analizowanie danych ze stron internetowych ma ogromny potencjał zastosowań w wielu dziedzinach, w tym w analizie danych, inteligencji korporacyjnej i raportowaniu śledczym.

Analitycy danych nieustannie poszukują nowych informacji i danych do modyfikacji i analizy. Przeszukiwanie internetu w poszukiwaniu konkretnych informacji jest obecnie jedną z najpopularniejszych metod.

Czy jesteś przygotowany na swoje pierwsze doświadczenie ze skrobaniem sieci? Ale najpierw musisz zrozumieć, czym właściwie jest web scraping i niektóre z jego podstaw, a następnie porozmawiamy o najlepszych technikach web scrapingu.

Co to jest skrobanie sieci?

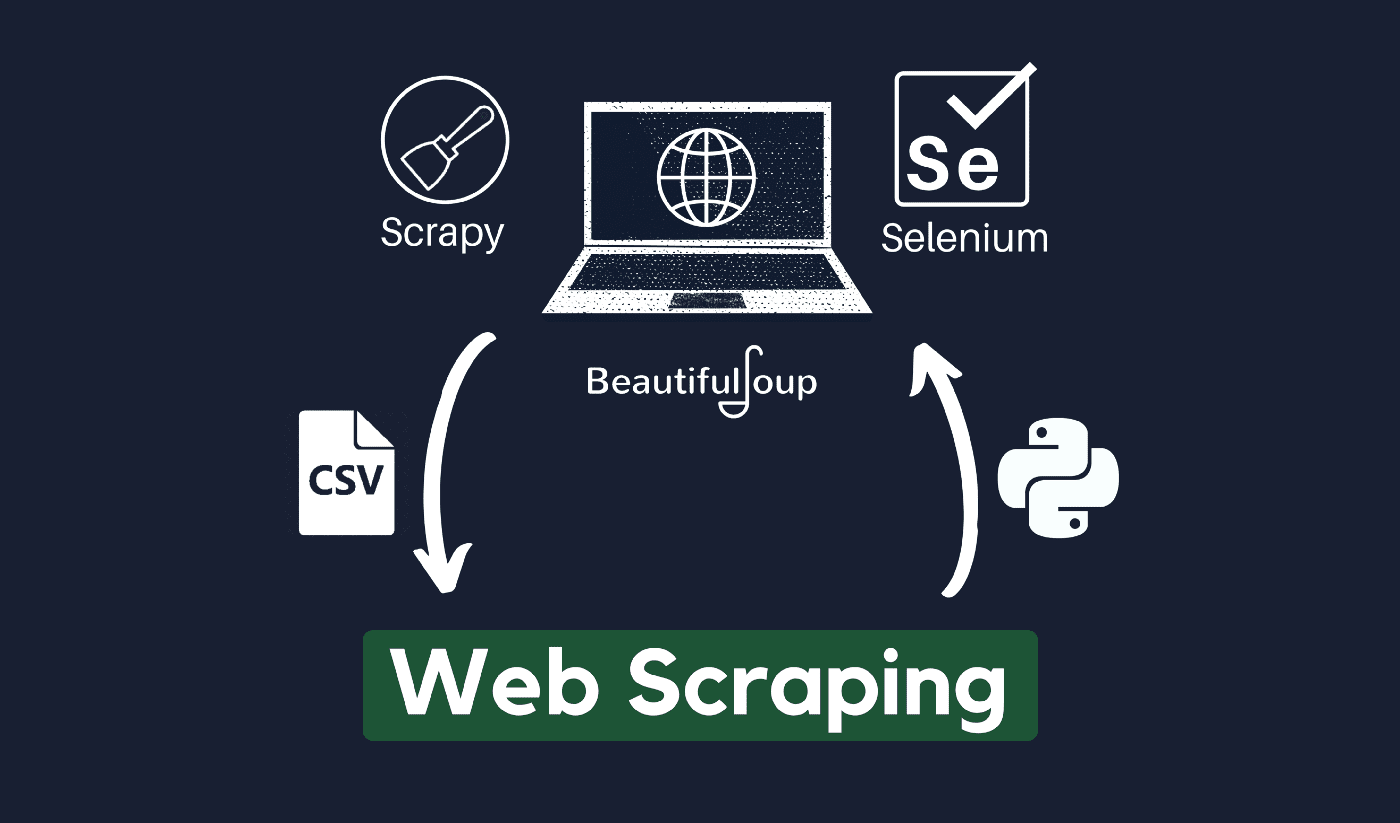

Technika zbierania i przetwarzania nieprzetworzonych danych z sieci jest znana jako web scraping, a społeczność Pythona opracowała kilka dość potężnych narzędzi do scrapingu. A potok danych służy do przetwarzania i przechowywania tych danych w uporządkowany sposób.

Skrobanie stron internetowych jest dziś powszechną praktyką z wieloma zastosowaniami:

- Firmy zajmujące się marketingiem i sprzedażą mogą gromadzić dane związane z potencjalnymi klientami, korzystając ze skrobania stron internetowych.

- Firmy z branży nieruchomości mogą uzyskiwać informacje o nowych inwestycjach, nieruchomościach na sprzedaż itp., korzystając ze skrobania stron internetowych.

- Witryny porównujące ceny, takie jak Trivago, często wykorzystują web scraping, aby uzyskać dane o produktach i cenach z różnych witryn e-commerce.

Możesz zeskrobać sieć za pomocą różnych języki programowania, a każdy język programowania ma różne biblioteki, które mogą pomóc w osiągnięciu tego samego. Jednym z najpopularniejszych, zaufanych i legalnych programów używanych do skutecznego skrobania sieci jest Python.

O Pythonie

Python jest najpopularniejszym językiem do scrapingu opracowanym i wprowadzonym na rynek w 1991 roku. Ten język programowania jest często używany do tworzenia stron internetowych, pisania kodu, tworzenia oprogramowania, tworzenia skryptów systemowych i innych rzeczy. Program jest kamieniem węgielnym sektora online i jest szeroko stosowany w handlu na całym świecie.

Aplikacje internetowe można tworzyć na serwerze przy użyciu języka Python. Może być używany w połączeniu z aplikacjami do budowania procesów i łączenia z systemami baz danych. Pliki mogą być również przez niego odczytywane i zmieniane.

Może być również używany do zarządzania ogromnymi danymi, przeprowadzania skomplikowanych operacji matematycznych, przyspieszania procesu prototypowania lub tworzenia oprogramowania gotowego do produkcji.

Jak używać Pythona do skrobania stron internetowych?

Prawdopodobnie będziesz musiał przejść przez trzy kroki, aby zeskrobać i wyodrębnić dowolne informacje z Internetu: uzyskanie kodu HTML, uzyskanie drzewa HTML i wreszcie wyodrębnienie informacji z drzewa.

Możliwe jest pobranie kodu HTML z danej Witryny za pomocą biblioteki Requests. Drzewo HTML zostanie następnie przeanalizowane i wyodrębnione przy użyciu PięknaZupa, a następnie dane można organizować tylko przy użyciu języka Python.

Zawsze zaleca się sprawdzenie zasad dopuszczalnego użytkowania witryny docelowej, aby sprawdzić, czy dostęp do witryny za pomocą zautomatyzowanych narzędzi nie narusza warunków jej użytkowania przed użyciem talentów Pythona do skrobania sieci.

Jak działa zgarnianie stron internetowych?

Pająki są zwykle używane w Internecie skrobanie proces. Pobierają dokumenty HTML z odpowiednich stron internetowych, wyodrębniają niezbędną treść w oparciu o logikę biznesową, a następnie przechowują ją w określonym formacie.

Ta strona internetowa służy jako przewodnik do tworzenia wysoce skalowalnych scraperów.

Frameworki i podejścia Pythona w połączeniu z kilkoma fragmentami kodu mogą służyć do zbierania danych na wiele prostych sposobów. Dostępnych jest kilka przewodników, które mogą pomóc w zastosowaniu tego samego w praktyce.

Skrobanie pojedynczej strony jest proste, ale zarządzanie kodem pająka, gromadzenie danych i utrzymanie hurtowni danych jest trudne w przypadku zeskrobywania milionów stron. Aby skrobanie było proste i precyzyjne, przyjrzymy się tym problemom i ich poprawkom.

Szybkie linki:

**Dodatkowa wskazówka: używaj rotujących adresów IP i usług proxy

Jak już masz jasny obraz, web scraping pozwala zbierać informacje z sieci za pomocą zestawu poleceń programistycznych. Ale jak musisz wiedzieć, twoje działania związane ze skrobaniem sieci można śledzić za pomocą twojego adresu IP.

Nie będzie to dużym problemem, jeśli dane, które zgarniasz, pochodzą z domeny publicznej. Ale jeśli zbierasz prywatne dane z, powiedzmy, specjalnej witryny medialnej, możesz wpaść w kłopoty, jeśli Twój adres IP zostanie wyśledzony.

Zasadniczo, aby zapobiec umieszczeniu pająka na czarnej liście, zawsze lepiej jest korzystać z usług proxy i zmieniać adresy IP.

W żadnym wypadku nie zachęcamy Cię do korzystania ze skrobania sieci w celu zbierania jakichkolwiek nielegalnych lub prywatnych danych lub oddawania się złośliwym działaniom spyware?

Ale jeśli gromadzisz dane, które mogą być prywatne, zaleca się maskowanie lub obracanie adres IP lub użyj serwera proxy, aby uniknąć śledzenia.

Możesz również przeczytać:

Czy web scraping jest legalny?

Oficjalnie w normach i wytycznych internetowych nigdzie nie jest powiedziane, że web scraping jest nielegalny. Z całą uczciwością, skrobanie sieci jest całkowicie legalne, pod warunkiem, że pracujesz na danych publicznych.

Pod koniec stycznia 2020 roku ogłoszono, że pobieranie publicznie dostępnych danych w celach niekomercyjnych jest całkowicie dozwolone.

Informacje, które są swobodnie dostępne dla ogółu społeczeństwa, to dane, które są dostępne dla każdego online bez hasła lub innego uwierzytelnienia. Tak więc informacje, które są publicznie dostępne, obejmują te, które można znaleźć w Wikipedii, mediach społecznościowych lub Szukaj w Google wyników.

Jednak niektóre strony internetowe wyraźnie zabraniają użytkownikom zbierania ich danych za pomocą web scrapingu. Skrobanie danych z mediów społecznościowych jest czasami uważane za nielegalne.

Powodem tego jest to, że niektóre z nich nie są dostępne dla ogółu społeczeństwa, na przykład gdy użytkownik ustawia swoje informacje jako prywatne. W tym przypadku skrobanie tych informacji jest zabronione. Skrobanie informacji ze stron internetowych bez zgody właściciela również może być uznane za szkodliwe.

Wydobądź to, co najlepsze z sieci dzięki Web Scraping!

Zbieranie i analizowanie danych ze stron internetowych ma ogromny potencjał zastosowań w wielu dziedzinach, w tym w analizie danych, inteligencji korporacyjnej i raportowaniu śledczym.

Jedną z podstawowych umiejętności wymaganych przez analityka danych jest przeglądanie stron internetowych.

Pamiętaj, że nie wszyscy będą chcieli, abyś uzyskiwał dostęp do ich serwerów internetowych w celu uzyskania danych. Zanim zaczniesz zeskrobywać stronę internetową, upewnij się, że przeczytałeś Warunki użytkowania. Rozważ także czas wysyłania zapytań internetowych, aby uniknąć przeciążenia serwera.

Szybkie linki