Dünyanın en büyük bilgi kaynağı muhtemelen internette bulunur. Web sitelerinden veri toplamak ve analiz etmek, veri bilimi, kurumsal zeka ve araştırmacı raporlama dahil olmak üzere çok çeşitli alanlarda çok büyük potansiyel uygulamalara sahiptir.

Veri bilimcileri, değiştirmek ve analiz etmek için sürekli olarak yeni bilgiler ve veriler arıyorlar. Belirli bilgiler için interneti kazımak, şu anda bunu yapmanın en popüler yöntemlerinden biridir.

İlk web kazıma deneyiminize hazır mısınız? Ama önce, web scraping'in gerçekte ne olduğunu ve bazı temellerini anlamalısınız ve ardından en iyi web scraping tekniklerinden bahsedeceğiz.

Web Kazıma nedir?

Web'den ham veri toplama ve işleme tekniği, web scraping olarak bilinir ve Python topluluğu bazı oldukça güçlü web scraping araçları geliştirmiştir. A veri hattı bu verileri yapılandırılmış bir şekilde işlemek ve depolamak için kullanılır.

Web kazıma, günümüzde çok sayıda uygulamada yaygın bir uygulamadır:

- Pazarlama ve satış işletmeleri, web kazıma özelliğini kullanarak müşteri adayıyla ilgili verileri toplayabilir.

- Emlak şirketleri, web scraping kullanarak yeni gelişmeler, satılık mülkler vb.

- Trivago gibi fiyat karşılaştırma siteleri, farklı e-ticaret sitelerinden ürün ve fiyat verilerini almak için sıklıkla web scraping kullanır.

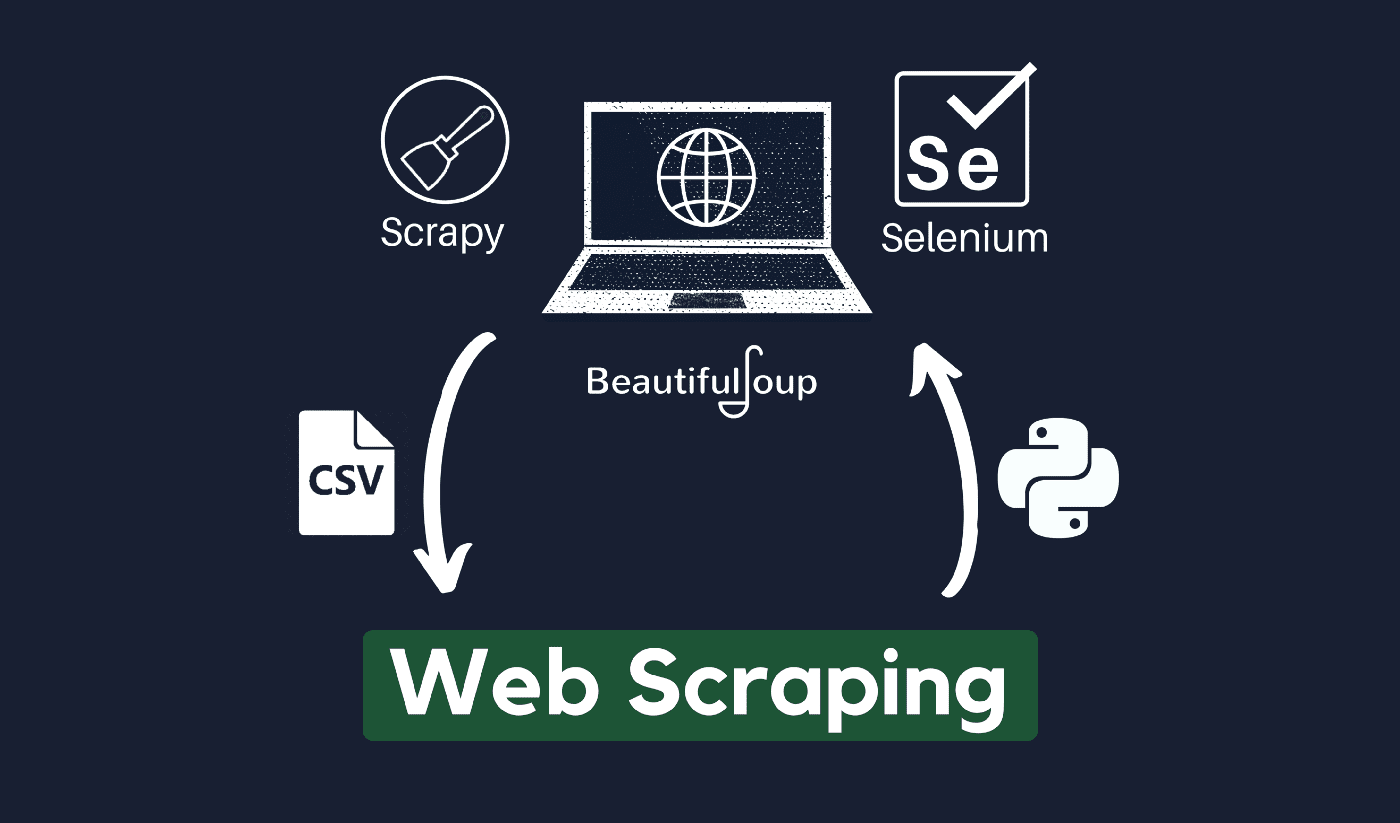

Web'i çeşitli kullanarak kazıyabilirsiniz. Programlama dillerive her programlama dilinde aynı şeyi başarmanıza yardımcı olabilecek çeşitli kitaplıklar bulunur. Etkili web kazıma için kullanılan en popüler, güvenilir ve yasal programlardan biri Python'dur.

Python hakkında

Python, 1991'de geliştirilen ve kullanıma sunulan en popüler kazıma dilidir. Bu programlama dili sıklıkla web siteleri oluşturmak, kod yazmak, yazılım oluşturmak, sistem komut dosyaları oluşturmak ve diğer şeyler için kullanılır. Program, çevrimiçi sektörün mihenk taşıdır ve dünya çapında ticarette yaygın olarak kullanılmaktadır.

Python kullanılarak bir sunucu üzerinde web uygulamaları geliştirilebilir. Süreçler oluşturmak ve veritabanı sistemlerine bağlanmak için uygulamalarla birlikte kullanılabilir. Dosyalar da onun tarafından okunabilir ve değiştirilebilir.

Ayrıca, büyük verileri yönetmek, karmaşık matematik işlemlerini gerçekleştirmek, prototip sürecini hızlandırmak veya üretime hazır yazılımlar oluşturmak için de kullanılabilir.

Python'u web kazıma için nasıl kullanabilirsiniz?

İnternetten herhangi bir bilgiyi kazımak ve çıkarmak için muhtemelen üç adımdan geçmeniz gerekecek: HTML'yi elde etmek, HTML ağacını almak ve son olarak ağaçtan bilgileri çıkarmak.

İstekler kitaplığı kullanılarak belirli bir Siteden HTML kodu almak mümkündür. HTML ağacı daha sonra ayrıştırılacak ve kullanılarak ayıklanacaktır. Güzel çorba, ve veriler daha sonra yalnızca Python kullanılarak düzenlenebilir.

Python yeteneklerinizi web kazıma için kullanmadan önce otomatik araçlar kullanarak web sitesine erişmenin kullanım koşullarının ihlali olup olmadığını görmek için hedef web sitenizin kabul edilebilir kullanım politikasını kontrol etmeniz her zaman önerilir.

Web kazıma nasıl çalışır?

Örümcekler genellikle çevrimiçi olarak kullanılır. kazıma işlem. HTML belgelerini ilgili web sitelerinden alır, iş mantığına göre gerekli içeriği çıkarır ve ardından belirli bir biçimde depolar.

Bu web sitesi, yüksek düzeyde ölçeklenebilir kazıyıcılar oluşturmak için bir kılavuz görevi görür.

Birkaç kod parçacığıyla birleştirilmiş Python çerçeveleri ve yaklaşımları, verileri çeşitli basit yollarla kazımak için kullanılabilir. Aynısını uygulamaya koymanıza yardımcı olabilecek çeşitli kılavuzlar mevcuttur.

Tek bir sayfayı kazımak basittir, ancak örümcek kodunu yönetmek, veri toplamak ve bir veri ambarının bakımını yapmak milyonlarca sayfayı kazırken zordur. Kazıma işlemini basit ve hassas hale getirmek için bu sorunları ve düzeltmelerini inceleyeceğiz.

Hızlı Linkler:

**Ek İpucu: Dönen IP'leri ve Proxy Hizmetlerini kullanın

Resmi açıkça gördüğünüz gibi, web kazıma, bir dizi programlama komutu kullanarak web'den bilgi toplamanıza olanak tanır. Ancak bilmeniz gerektiği gibi, web scraping faaliyetleriniz IP adresiniz üzerinden takip edilebilir.

Verileri kamuya açık bir alandan topluyorsanız, bu pek bir sorun olmayacaktır. Ancak, örneğin özel bir medya sitesinden özel verileri kopyalıyorsanız, IP adresiniz izlenirse başınız belaya girebilir.

Bu nedenle, temelde, örümceğinizin kara listeye alınmasını önlemek için, proxy hizmetlerini kullanmak ve IP adreslerini değiştirmek her zaman tercih edilir.

Herhangi bir yasa dışı veya özel veri toplamak veya bazı kötü amaçlı casus yazılım faaliyetlerine kendinizi kaptırmak için web scraping'i kullanmanızı hiçbir şekilde teşvik etmiyoruz?

Ancak özel olabilecek veriler topluyorsanız, verilerinizi maskelemeniz veya döndürmeniz önerilir. IP adresi veya izlenmekten kaçınmak için bir proxy sunucusu kullanın.

Ayrıca okumak isteyebilirsiniz:

Web kazıma yasal mı?

Resmi olarak, internet normlarında ve yönergelerinde web kazımanın yasa dışı olduğu hiçbir yerde belirtilmemiştir. Adil olmak gerekirse, herkese açık veriler üzerinde çalışıyorsanız, web kazıma yapmak tamamen yasaldır.

Ocak 2020'nin sonlarında, halka açık verilerin ticari olmayan amaçlarla kazınmasına tamamen izin verildiği açıklandı.

Genel halkın ücretsiz olarak erişebildiği bilgiler, parola veya başka bir kimlik doğrulaması olmadan herkesin çevrimiçi olarak erişebildiği verilerdir. Bu nedenle, halka açık olan bilgiler Wikipedia'da, sosyal medyada veya Google arama Sonuçlar.

Bununla birlikte, bazı web siteleri, kullanıcıların web kazıma ile verilerini kazımasını açıkça yasaklar. Sosyal medyadan veri kazımak bazen yasa dışı kabul edilir.

Bunun nedeni, bir kullanıcının bilgilerini gizli yaptığı durumlarda olduğu gibi, bazılarının genel halk tarafından erişilebilir olmamasıdır. Bu durumda, bu bilgilerin kazınması yasaktır. Sahibinin izni olmadan web sitelerinden bilgi kazımak da zararlı olarak kabul edilebilir.

Web Scraping ile web'den en iyi şekilde yararlanın!

Web sitelerinden veri toplamak ve analiz etmek, veri bilimi, kurumsal zeka ve araştırmacı raporlama dahil olmak üzere çok çeşitli alanlarda çok büyük potansiyel uygulamalara sahiptir.

Bir veri bilimcinin ihtiyaç duyduğu temel yeteneklerden biri web kazımadır.

Herkesin veriler için web sunucularına erişmenizi istemeyeceğini unutmayın. Bir web sitesini kazımaya başlamadan önce Kullanım Koşullarını okuduğunuzdan emin olun. Ayrıca, bir sunucunun aşırı yüklenmesini önlemek için web sorgularınızı zamanlarken dikkatli olun.

Linkler