De grootste bron van informatie ter wereld is waarschijnlijk te vinden op internet. Het verzamelen en analyseren van gegevens van websites heeft enorme potentiële toepassingen op een groot aantal gebieden, waaronder datawetenschap, bedrijfsinformatie en onderzoeksrapportage.

Datawetenschappers zijn voortdurend op zoek naar nieuwe informatie en gegevens om aan te passen en te analyseren. Het internet afzoeken naar specifieke informatie is momenteel een van de meest populaire methoden om dit te doen.

Ben je voorbereid op je eerste webscraping-ervaring? Maar eerst moet u begrijpen wat webschrapen eigenlijk is en enkele van de grondbeginselen ervan, en dan zullen we het hebben over de beste webschraptechnieken.

Wat is webscraping?

De techniek van het verzamelen en verwerken van onbewerkte gegevens van het web staat bekend als webschrapen en de Python-gemeenschap heeft een aantal behoorlijk krachtige webschrapingtools ontwikkeld. A datapijplijn wordt gebruikt om deze gegevens gestructureerd te verwerken en op te slaan.

Webscraping is tegenwoordig een gangbare praktijk met tal van toepassingen:

- Marketing- en verkoopbedrijven kunnen leadgerelateerde gegevens verzamelen door webscraping te gebruiken.

- Vastgoedbedrijven kunnen via webscraping informatie verkrijgen over nieuwe ontwikkelingen, te koop staande panden, enz.

- Prijsvergelijkingswebsites zoals Trivago maken vaak gebruik van webscraping om product- en prijsgegevens van verschillende e-commercewebsites te krijgen.

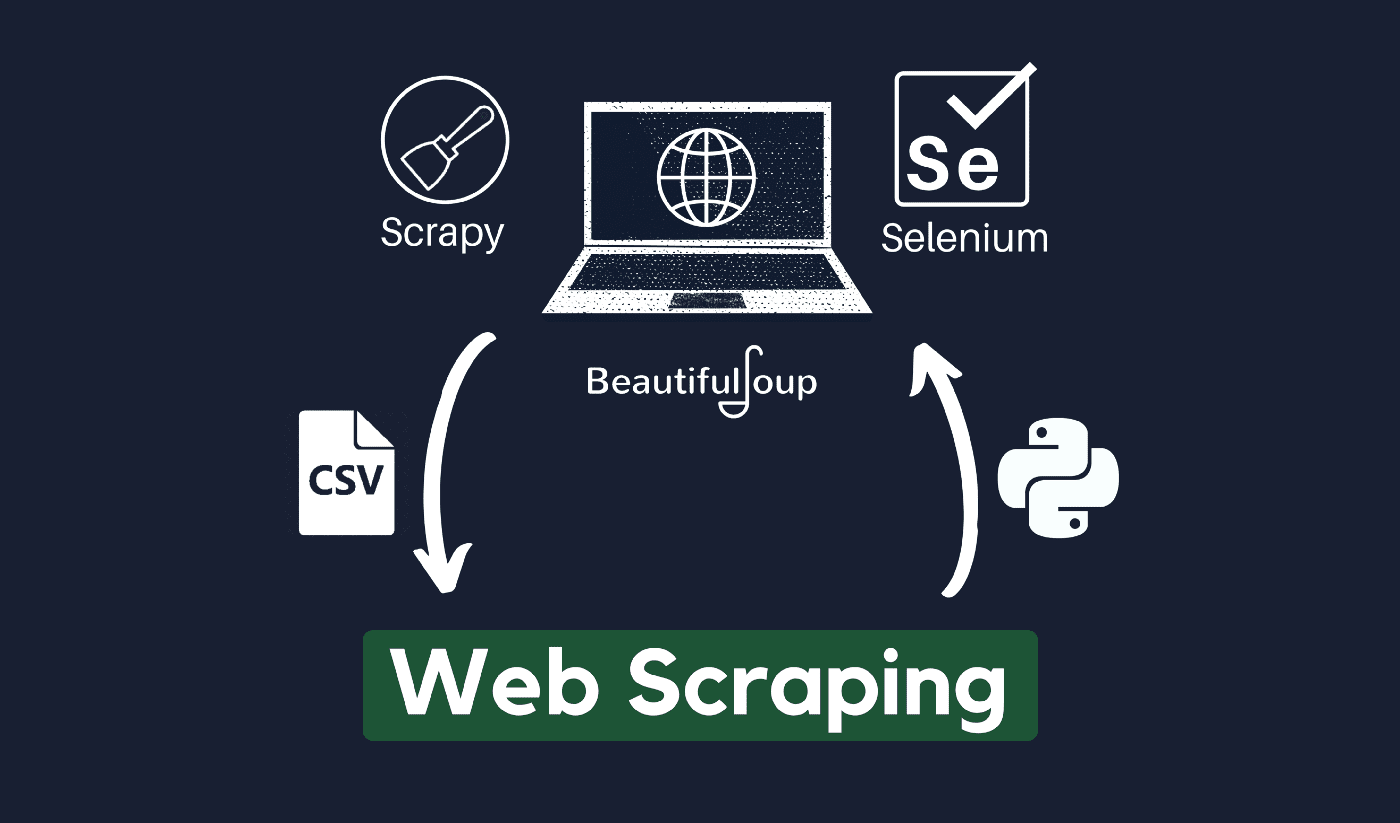

U kunt het web schrapen met behulp van een verscheidenheid aan programmeertalen, en elke programmeertaal heeft een verscheidenheid aan bibliotheken die u kunnen helpen hetzelfde te bereiken. Een van de meest populaire, vertrouwde en legitieme programma's die worden gebruikt voor effectief webschrapen, is Python.

Over Python

Python is de meest populaire taal voor scraping, ontwikkeld en gelanceerd in 1991. Deze programmeertaal wordt vaak gebruikt voor het maken van websites, het schrijven van code, het maken van software, het maken van systeemscripts en andere dingen. Het programma is een hoeksteen van de online sector en wordt veel gebruikt in de handel over de hele wereld.

Webapplicaties kunnen op een server worden ontwikkeld met behulp van Python. Het kan worden gebruikt in combinatie met applicaties om processen te bouwen en te koppelen aan databasesystemen. Bestanden kunnen er ook door worden gelezen en gewijzigd.

Het kan ook worden gebruikt om enorme hoeveelheden gegevens te beheren, ingewikkelde wiskundige bewerkingen uit te voeren, het prototypeproces te versnellen of software te maken die klaar is voor productie.

Hoe kun je Python gebruiken voor webschrapen?

U zult waarschijnlijk drie stappen moeten doorlopen om informatie van internet te schrapen en te extraheren: HTML ophalen, de HTML-boom ophalen en ten slotte de informatie uit de boom halen.

Het is mogelijk om HTML-code van een bepaalde site op te halen met behulp van de Requests-bibliotheek. De HTML-boom wordt vervolgens geparseerd en geëxtraheerd met behulp van Mooie soep, en de gegevens kunnen dan worden georganiseerd met alleen Python.

Het is altijd raadzaam om het acceptabele gebruiksbeleid van uw doelwebsite te controleren om te zien of toegang tot de website met behulp van geautomatiseerde tools een schending is van de gebruiksvoorwaarden voordat u uw Python-talenten gebruikt voor webscraping.

Hoe werkt webscraping?

Spinnen worden meestal online gebruikt schrapen proces. Ze halen HTML-documenten op van relevante websites, extraheren de benodigde inhoud op basis van bedrijfslogica en slaan deze vervolgens op in een bepaald formaat.

Deze website dient als leidraad voor het maken van zeer schaalbare scrappers.

Python-frameworks en -benaderingen in combinatie met een paar codefragmenten kunnen op een aantal eenvoudige manieren worden gebruikt om gegevens te schrapen. Er zijn verschillende handleidingen beschikbaar die u kunnen helpen hetzelfde in de praktijk te brengen.

Het schrapen van een enkele pagina is eenvoudig, maar het beheren van de spidercode, het verzamelen van gegevens en het onderhoud van een datawarehouse is moeilijk bij het schrapen van miljoenen pagina's. Om scraping eenvoudig en nauwkeurig te maken, zullen we deze problemen en hun oplossingen onderzoeken.

Snelle links:

**Extra tip: gebruik roterende IP's en proxyservices

Zoals u duidelijk hebt begrepen, kunt u met webscraping informatie van internet verzamelen met behulp van een reeks programmeeropdrachten. Maar zoals u moet weten, kunnen uw webscraping-activiteiten worden getraceerd via uw IP-adres.

Dit zal niet echt een probleem zijn als de gegevens die u uit een openbaar domein haalt. Maar als u privégegevens van bijvoorbeeld een speciale mediasite schraapt, kunt u in de problemen komen als uw IP-adres wordt opgespoord.

Dus om te voorkomen dat uw spider op de zwarte lijst komt, verdient het altijd de voorkeur om proxyservices te gebruiken en IP-adressen te wijzigen.

We moedigen u in geen geval aan om webscraping te gebruiken voor het verzamelen van illegale of privégegevens of om u over te geven aan kwaadaardige spywareactiviteiten?

Maar als u gegevens verzamelt die mogelijk privé zijn, is het raadzaam om uw gegevens te maskeren of te roteren IP-adres of gebruik een proxyserver om te voorkomen dat u wordt getraceerd.

Misschien lees je ook graag:

Is webscraping legaal?

Officieel staat nergens in de internetnormen en -richtlijnen dat webscraping illegaal is. Eerlijk gezegd is webscraping volkomen legaal om te doen, op voorwaarde dat u met openbare gegevens werkt.

Eind januari 2020 werd bekend gemaakt dat het schrapen van openbaar beschikbare data voor niet-commerciële doeleinden geheel is toegestaan.

Informatie die vrij toegankelijk is voor het grote publiek is data die voor iedereen online toegankelijk is zonder wachtwoord of andere authenticatie. Informatie die openbaar beschikbaar is, omvat dus informatie die kan worden gevonden op Wikipedia, sociale media of Google zoeken resultaten.

Sommige websites verbieden gebruikers echter expliciet om hun gegevens te schrapen met webschrapen. Het schrapen van gegevens van sociale media wordt soms als illegaal beschouwd.

De reden hiervoor is dat een deel ervan niet toegankelijk is voor het grote publiek, bijvoorbeeld wanneer een gebruiker zijn informatie privé maakt. In dit geval is het schrappen van deze informatie verboden. Het schrapen van informatie van websites zonder toestemming van de eigenaar kan ook als schadelijk worden beschouwd.

Haal het beste uit het web met Web Scraping!

Het verzamelen en analyseren van gegevens van websites heeft enorme potentiële toepassingen op een groot aantal gebieden, waaronder datawetenschap, bedrijfsinformatie en onderzoeksrapportage.

Een van de fundamentele vaardigheden die een datawetenschapper nodig heeft, is webschrapen.

Houd er rekening mee dat niet iedereen wil dat u toegang heeft tot hun webservers voor gegevens. Voordat u begint met het schrapen van een website, moet u ervoor zorgen dat u de gebruiksvoorwaarden hebt gelezen. Wees ook attent bij het timen van uw webquery's om te voorkomen dat een server wordt overweldigd.

Links