A maior fonte de informação do mundo provavelmente é encontrada na Internet. A coleta e análise de dados de sites tem um vasto potencial de aplicações em uma ampla variedade de campos, incluindo ciência de dados, inteligência corporativa e relatórios investigativos.

Os cientistas de dados estão constantemente procurando novas informações e dados para modificar e analisar. Raspar a Internet em busca de informações específicas é atualmente um dos métodos mais populares para fazer isso.

Você está preparado para sua primeira experiência de raspagem na web? Mas primeiro, você deve compreender o que realmente é o web scraping e alguns de seus fundamentos, e então falaremos sobre as melhores técnicas de web scraping.

O que é raspagem na Web?

A técnica de coleta e processamento de dados brutos da Web é conhecida como web scraping, e a comunidade Python desenvolveu algumas ferramentas bastante potentes de web scraping. A pipeline de dados é usado para processar e armazenar esses dados de maneira estruturada.

A raspagem da Web é uma prática comum hoje em dia com inúmeras aplicações:

- As empresas de marketing e vendas podem coletar dados relacionados a leads usando a raspagem da web.

- As empresas imobiliárias podem obter informações sobre novos empreendimentos, propriedades à venda, etc. usando a raspagem da web.

- Sites de comparação de preços, como o Trivago, frequentemente empregam raspagem na web para obter dados de produtos e preços de diferentes sites de comércio eletrônico.

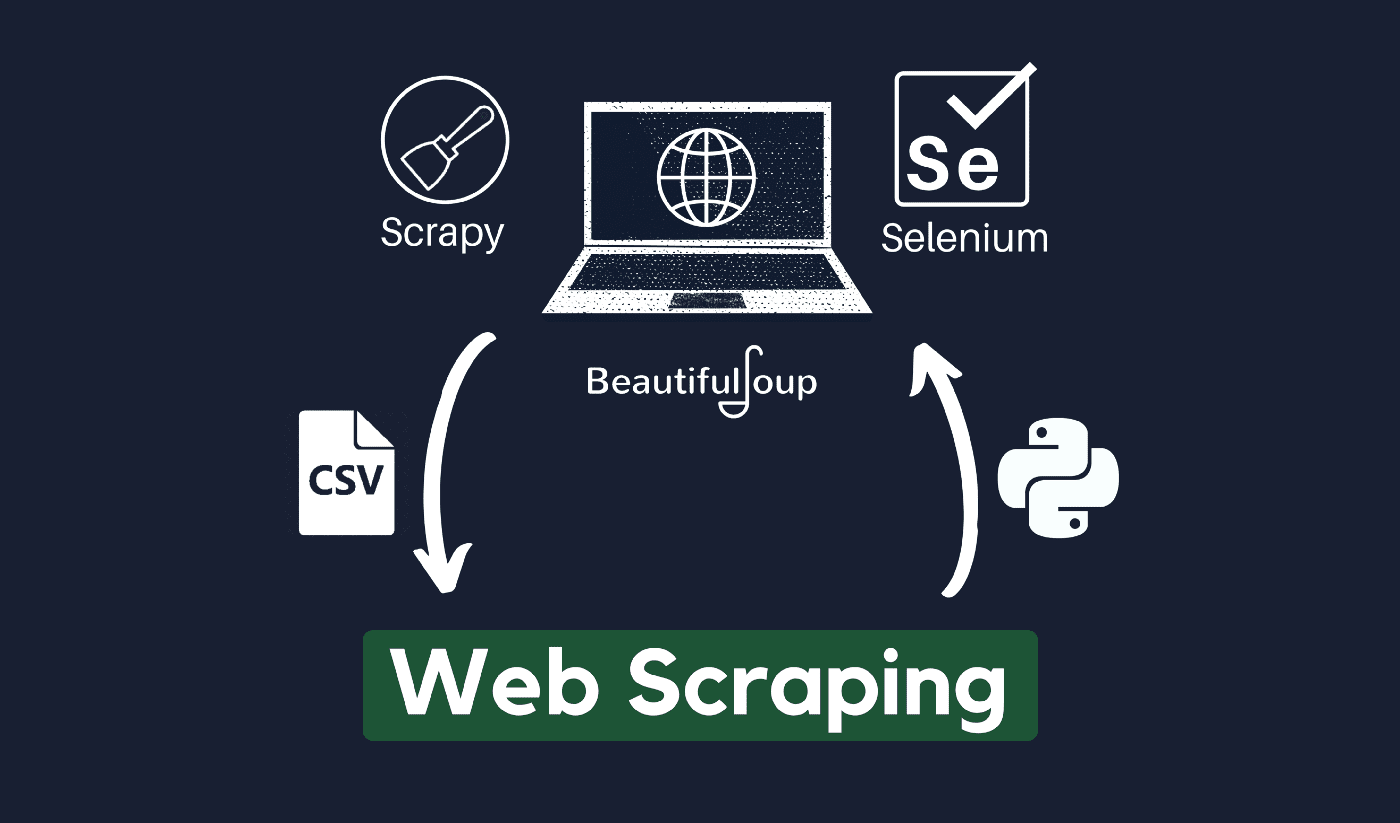

Você pode raspar a web usando uma variedade de linguagens de programação, e cada linguagem de programação possui uma variedade de bibliotecas que podem ajudá-lo a realizar a mesma coisa. Um dos programas mais populares, confiáveis e legítimos usados para web scraping eficaz é o Python.

Sobre Python

Python é a linguagem mais popular para scraping desenvolvida e lançada em 1991. Essa linguagem de programação é frequentemente usada para criar sites, escrever códigos, criar softwares, criar scripts de sistema e outras coisas. O programa é um dos pilares do setor online e é amplamente utilizado no comércio em todo o mundo.

Aplicativos da Web podem ser desenvolvidos em um servidor usando Python. Ele pode ser usado em conjunto com aplicativos para criar processos e vincular-se a sistemas de banco de dados. Os arquivos também podem ser lidos e alterados por ele.

Ele também pode ser usado para gerenciar dados massivos, realizar operações matemáticas complicadas, acelerar o processo de protótipo ou criar software pronto para produção.

Como você pode usar Python para web scraping?

Você provavelmente precisará passar por três etapas para coletar e extrair qualquer informação da Internet: obter HTML, obter a árvore HTML e, finalmente, extrair as informações da árvore.

É possível recuperar o código HTML de um determinado Site usando a biblioteca Requests. A árvore HTML será então analisada e extraída usando Linda Sopa, e os dados podem então ser organizados usando apenas Python.

É sempre aconselhável verificar a política de uso aceitável do site de destino para ver se acessar o site usando ferramentas automatizadas é uma violação de suas condições de uso antes de usar seus talentos Python para web scraping.

Como funciona a raspagem da web?

Spiders são normalmente usados no online raspagem processo. Eles recuperam documentos HTML de sites relevantes, extraem o conteúdo necessário com base na lógica de negócios e o armazenam em um determinado formato.

Este site serve como um guia para a criação de scrappers altamente escaláveis.

As estruturas e abordagens do Python combinadas com alguns trechos de código podem ser usadas para coletar dados de várias maneiras diretas. Existem vários guias disponíveis que podem ajudá-lo a colocar o mesmo em prática.

Raspar uma única página é simples, mas gerenciar o código do spider, coletar dados e manter um data warehouse é difícil ao raspar milhões de páginas. Para tornar a raspagem simples e precisa, examinaremos esses problemas e suas correções.

Links rápidos:

**Dica adicional: use IPs rotativos e serviços de proxy

Como você entendeu claramente, o web scraping permite que você colete informações da web usando um conjunto de comandos de programação. Mas como você deve estar ciente, suas atividades de web scraping podem ser rastreadas através do seu endereço IP.

Isso não será um grande problema se os dados que você está extraindo de um domínio público. Mas se você estiver coletando dados privados de, digamos, um site de mídia especial, poderá ter problemas se seu endereço IP for rastreado.

Então, basicamente, para evitar que seu spider entre na lista negra, é sempre preferível usar serviços de proxy e alterar endereços IP.

De forma alguma estamos incentivando você a usar a raspagem da Web para coletar quaisquer dados ilegais ou privados, ou se entregar a algumas atividades maliciosas de spyware?

Mas se você estiver coletando dados que possam ser privados, é recomendável mascarar ou girar seu Endereço IP ou use um servidor proxy para evitar ser rastreado.

Você também pode gostar de ler:

A raspagem da web é legal?

Oficialmente, não é declarado em nenhum lugar nas normas e diretrizes da Internet que a raspagem da web é ilegal. Com toda a justiça, a raspagem da web é totalmente legal de se fazer, desde que você esteja trabalhando com dados públicos.

No final de janeiro de 2020, foi anunciado que a extração de dados disponíveis publicamente para fins não comerciais era totalmente permitida.

As informações livremente acessíveis ao público em geral são dados acessíveis a todos on-line sem uma senha ou outra autenticação. Portanto, as informações disponíveis publicamente incluem aquelas que podem ser encontradas na Wikipédia, mídias sociais ou A pesquisa do Google resultados.

No entanto, alguns sites proíbem explicitamente que os usuários raspem seus dados com a raspagem da web. A extração de dados das mídias sociais às vezes é considerada ilegal.

A razão para isso é que algumas delas não são acessíveis ao público em geral, como quando um usuário torna suas informações privadas. Nesse caso, é proibido raspar essas informações. A extração de informações de sites sem o consentimento do proprietário também pode ser considerada prejudicial.

Obtenha o melhor da web através do Web Scraping!

A coleta e análise de dados de sites tem um vasto potencial de aplicações em uma ampla variedade de campos, incluindo ciência de dados, inteligência corporativa e relatórios investigativos.

Uma das habilidades fundamentais que um cientista de dados requer é a raspagem da web.

Lembre-se de que nem todos desejam que você acesse seus servidores da Web para obter dados. Antes de começar a raspar um site, certifique-se de ter lido as Condições de Uso. Além disso, tenha cuidado ao cronometrar suas consultas na Web para evitar sobrecarregar um servidor.

Quick Links