Самый большой в мире источник информации, вероятно, находится в Интернете. Сбор и анализ данных с веб-сайтов имеет широкие потенциальные возможности применения в самых разных областях, включая науку о данных, корпоративную аналитику и отчеты о расследованиях.

Исследователи данных постоянно ищут новую информацию и данные для модификации и анализа. Поиск в Интернете конкретной информации в настоящее время является одним из самых популярных способов сделать это.

Готовы ли вы к своему первому опыту парсинга веб-страниц? Но сначала вы должны понять, что такое веб-скрейпинг и некоторые его основы, а затем мы поговорим о лучших методах веб-скрейпинга.

Что такое Web Scraping?

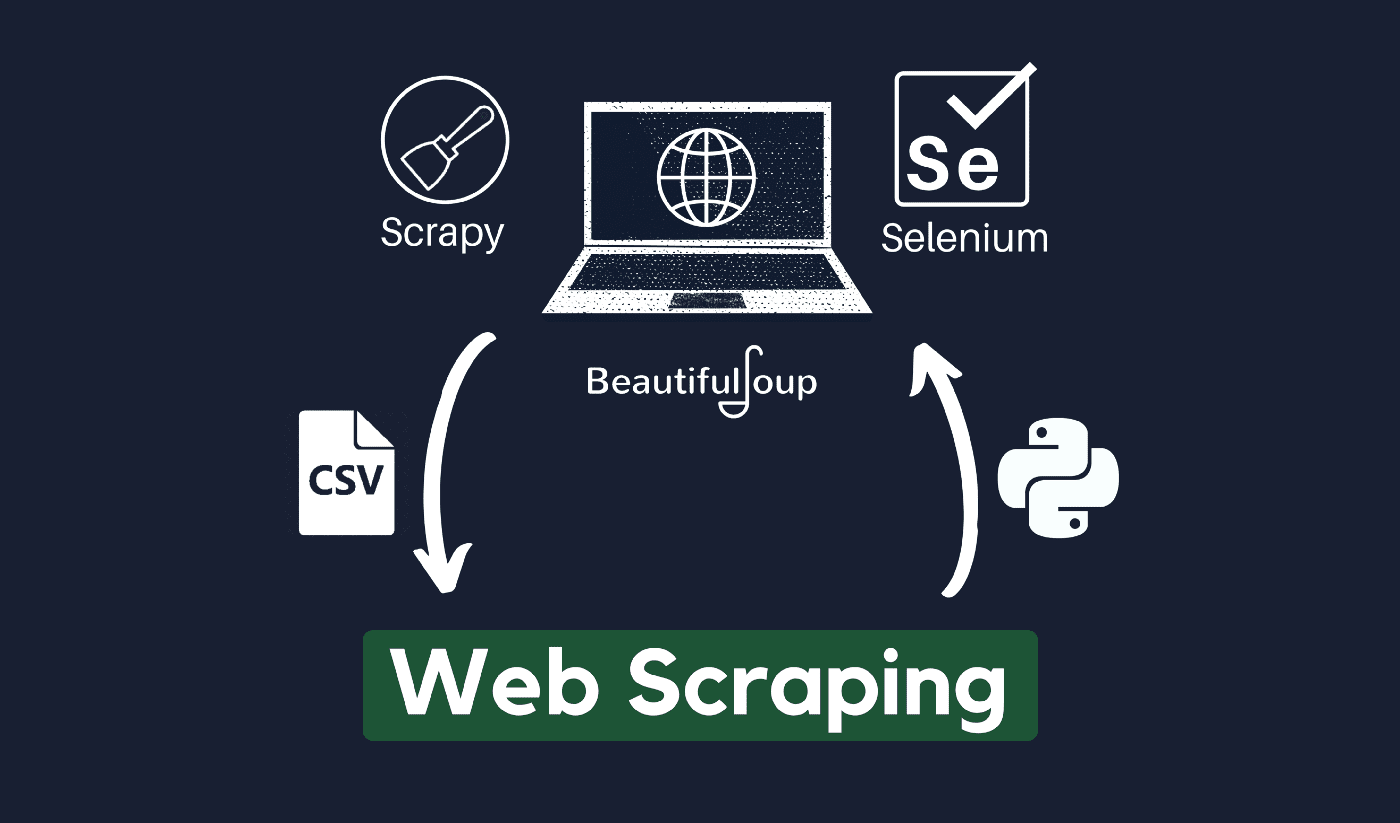

Техника сбора и обработки необработанных данных из Интернета известна как парсинг веб-страниц, и сообщество Python разработало несколько довольно мощных инструментов парсинга веб-страниц. А конвейер данных используется для обработки и хранения этих данных в структурированном виде.

Веб-скрапинг сегодня является обычной практикой с многочисленными приложениями:

- Компании, занимающиеся маркетингом и продажами, могут собирать данные о лидах с помощью парсинга веб-страниц.

- Компании, занимающиеся недвижимостью, могут получать информацию о новостройках, выставленных на продажу объектах и т. д., используя веб-скрапинг.

- Веб-сайты сравнения цен, такие как Trivago, часто используют веб-скрапинг для получения данных о продуктах и ценах с разных веб-сайтов электронной коммерции.

Вы можете очистить Интернет, используя различные языки программирования, и каждый язык программирования имеет множество библиотек, которые могут помочь вам выполнить одно и то же. Одной из самых популярных, надежных и законных программ, используемых для эффективного веб-скрейпинга, является Python.

О Python

Python — самый популярный язык для парсинга, разработанный и запущенный в 1991 году. Этот язык программирования часто используется для создания веб-сайтов, написания кода, создания программного обеспечения, создания системных скриптов и других вещей. Программа является краеугольным камнем онлайн-сектора и широко используется в коммерции по всему миру.

Веб-приложения можно разрабатывать на сервере с использованием Python. Его можно использовать вместе с приложениями для создания процессов и связи с системами баз данных. Файлы также могут быть прочитаны и изменены им.

Его также можно использовать для управления большими объемами данных, выполнения сложных математических операций, ускорения процесса создания прототипа или создания программного обеспечения, готового к производству.

Как вы можете использовать Python для парсинга веб-страниц?

Вам, скорее всего, потребуется выполнить три шага, чтобы очистить и извлечь любую информацию из Интернета: получение HTML, получение дерева HTML и, наконец, извлечение информации из дерева.

Можно получить HTML-код с данного сайта с помощью библиотеки запросов. Затем HTML-дерево будет проанализировано и извлечено с помощью КрасивыйСуп, и затем данные могут быть организованы с использованием только Python.

Всегда рекомендуется проверить политику приемлемого использования вашего целевого веб-сайта, чтобы убедиться, что доступ к веб-сайту с помощью автоматизированных инструментов не является нарушением его условий использования, прежде чем использовать свои таланты Python для веб-скрейпинга.

Как работает очистка веб-страниц?

Пауки обычно используются в онлайне. выскабливание процесс. Они извлекают HTML-документы с соответствующих веб-сайтов, извлекают необходимый контент на основе бизнес-логики, а затем сохраняют его в определенном формате.

Этот веб-сайт служит руководством по созданию высокомасштабируемых скрапперов.

Фреймворки и подходы Python в сочетании с несколькими фрагментами кода можно использовать для извлечения данных несколькими простыми способами. Есть несколько доступных руководств, которые могут помочь вам применить то же самое на практике.

Парсинг одной страницы прост, но управлять кодом паука, собирать данные и поддерживать хранилище данных сложно при парсинге миллионов страниц. Чтобы сделать парсинг простым и точным, мы рассмотрим эти проблемы и способы их устранения.

Быстрые ссылки:

**Дополнительный совет: используйте чередующиеся IP-адреса и прокси-сервисы.

Как вы уже поняли, веб-скрапинг позволяет собирать информацию из Интернета с помощью набора программных команд. Но, как вы должны знать, ваши действия по очистке веб-страниц можно отследить по вашему IP-адресу.

Это не будет большой проблемой, если данные, которые вы собираете, находятся в открытом доступе. Но если вы собираете личные данные, скажем, со специального медиа-сайта, у вас могут возникнуть проблемы, если ваш IP-адрес будет отслежен.

Итак, в принципе, чтобы ваш паук не попал в черный список, всегда предпочтительнее использовать прокси-сервисы и менять IP-адреса.

Мы ни в коем случае не призываем вас использовать веб-скрапинг для сбора каких-либо незаконных или личных данных или заниматься какой-либо вредоносной шпионской деятельностью?

Но если вы собираете данные, которые могут быть конфиденциальными, рекомендуется маскировать или чередовать ваши IP-адрес или используйте прокси-сервер, чтобы избежать отслеживания.

Вы также можете прочитать:

Является ли веб-скрапинг законным?

Официально в интернет-нормах и руководствах нигде не указано, что парсинг является незаконным. Справедливости ради, парсинг веб-страниц абсолютно законен, если вы работаете с общедоступными данными.

В конце января 2020 года было объявлено, что сбор общедоступных данных в некоммерческих целях полностью разрешен.

Информация, которая находится в свободном доступе для широкой публики, — это данные, которые доступны всем в Интернете без пароля или другой аутентификации. Таким образом, общедоступная информация включает информацию, которую можно найти в Википедии, социальных сетях или Поиск в Google результаты.

Однако некоторые веб-сайты прямо запрещают пользователям очищать свои данные с помощью парсинга. Извлечение данных из социальных сетей иногда считается незаконным.

Причина этого в том, что некоторые из них недоступны для широкой публики, например, когда пользователь делает свою информацию конфиденциальной. В этом случае удаление этой информации запрещено. Соскребание информации с веб-сайтов без согласия владельца также может считаться вредным.

Получите максимум от Интернета с помощью Web Scraping!

Сбор и анализ данных с веб-сайтов имеет широкие потенциальные применения в самых разных областях, включая науку о данных, корпоративную аналитику и отчеты о расследованиях.

Одной из фундаментальных способностей, необходимых исследователю данных, является веб-скрапинг.

Имейте в виду, что не все захотят, чтобы вы обращались к их веб-серверам для получения данных. Прежде чем приступить к парсингу веб-сайта, убедитесь, что вы прочитали Условия использования. Кроме того, будьте внимательны при выборе времени для веб-запросов, чтобы не перегрузить сервер.

Полезное