Ang pinakamalaking mapagkukunan ng impormasyon sa mundo ay malamang na matatagpuan sa Internet. Ang pagkolekta at pagsusuri ng data mula sa mga website ay may malawak na potensyal na aplikasyon sa malawak na hanay ng mga larangan, kabilang ang data science, corporate intelligence, at pag-uulat sa pagsisiyasat.

Ang mga data scientist ay patuloy na naghahanap ng bagong impormasyon at data upang baguhin at pag-aralan. Ang pag-scrape sa internet para sa partikular na impormasyon ay kasalukuyang isa sa pinakasikat na paraan para gawin ito.

Handa ka na ba para sa iyong unang karanasan sa web scraping? Ngunit una, dapat mong maunawaan kung ano talaga ang web scraping at ang ilan sa mga pangunahing kaalaman nito, at pagkatapos ay pag-uusapan natin ang tungkol sa pinakamahusay na mga diskarte sa web scraping.

Ano ang Web Scraping?

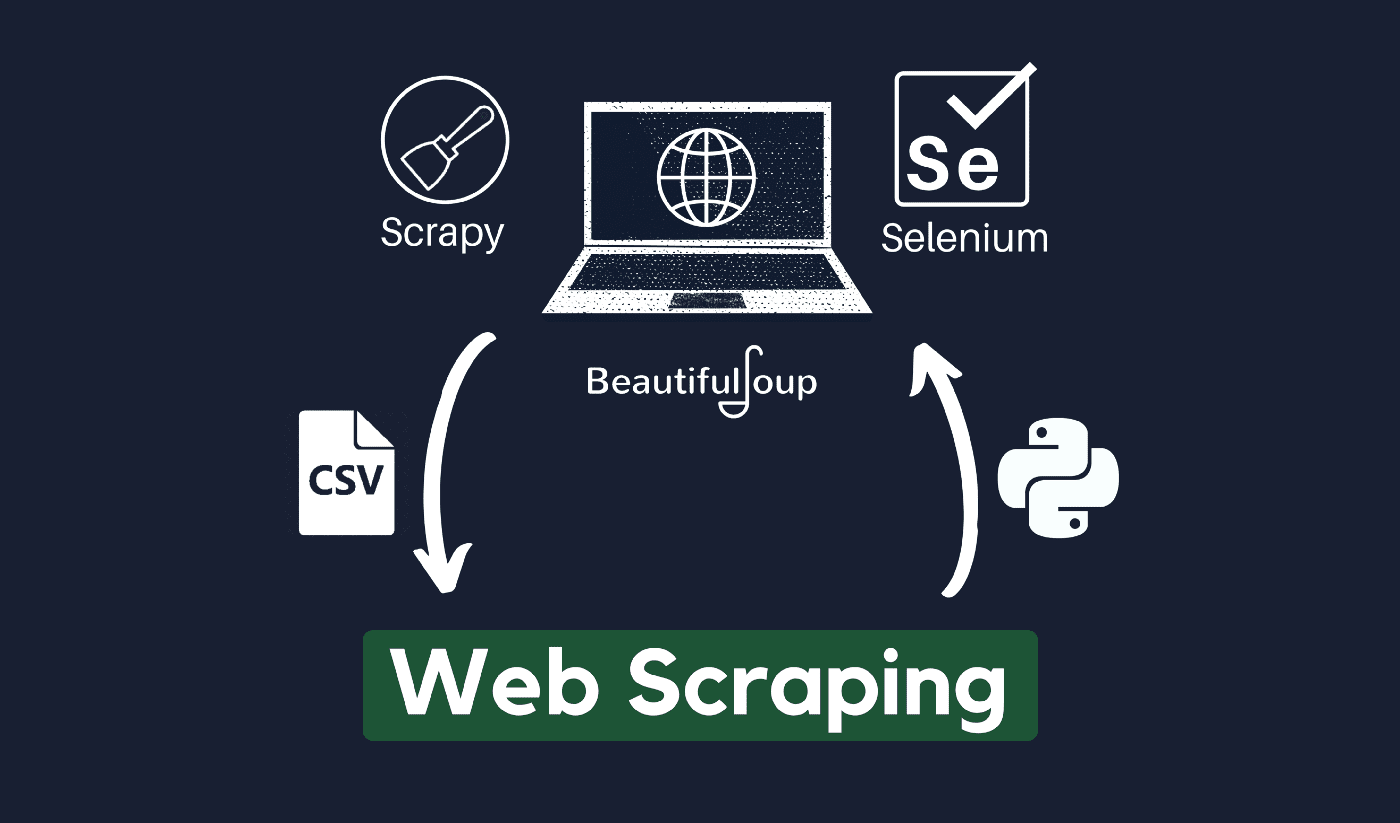

Ang pamamaraan ng pangangalap at pagproseso ng hilaw na data mula sa Web ay kilala bilang web scraping, at ang Python community ay nakabuo ng ilang medyo makapangyarihang web scraping tool. A pipeline ng data ay ginagamit upang iproseso at iimbak ang data na ito sa isang structured na paraan.

Ang pag-scrape sa web ay isang pangkaraniwang kasanayan ngayon na may maraming mga aplikasyon:

- Ang mga negosyo sa marketing at pagbebenta ay maaaring mangalap ng data na nauugnay sa lead sa pamamagitan ng paggamit ng web scraping.

- Ang mga kumpanya ng real estate ay maaaring makakuha ng impormasyon sa mga bagong development, for-sale property, atbp. sa pamamagitan ng paggamit ng web scraping.

- Ang mga website ng paghahambing ng presyo tulad ng Trivago ay madalas na gumagamit ng web scraping upang makakuha ng data ng produkto at pagpepresyo mula sa iba't ibang mga website ng e-commerce.

Maaari mong i-scrape ang web gamit ang iba't-ibang programming languages, at ang bawat programming language ay may iba't ibang mga aklatan na makakatulong sa iyong magawa ang parehong bagay. Ang isa sa pinakasikat, pinagkakatiwalaan, at legit na mga programang ginagamit para sa epektibong web scraping ay ang Python.

Tungkol sa Python

Ang Python ay ang pinakasikat na wika para sa pag-scrap na binuo at inilunsad noong 1991. Ang programming language na ito ay madalas na ginagamit para sa paglikha ng mga website, pagsulat ng code, paglikha ng software, paglikha ng mga script ng system, at iba pang mga bagay. Ang programa ay isang pundasyon ng online na sektor at malawakang ginagamit sa komersyo sa buong mundo.

Maaaring mabuo ang mga web application sa isang server gamit ang Python. Maaari itong magamit kasabay ng mga application para bumuo ng mga proseso at mag-link sa mga database system. Ang mga file ay maaari ding basahin at baguhin nito.

Maaari rin itong magamit upang pamahalaan ang napakalaking data, magsagawa ng mga kumplikadong operasyon sa matematika, pabilisin ang proseso ng prototype, o lumikha ng software na handa na para sa produksyon.

Paano mo magagamit ang Python para sa web scraping?

Malamang na kailangan mong dumaan sa tatlong hakbang upang mag-scrape at mag-extract ng anumang impormasyon mula sa internet: pagkuha ng HTML, pagkuha ng HTML tree, at sa wakas ay pagkuha ng impormasyon mula sa tree.

Posibleng kunin ang HTML code mula sa isang naibigay na Site gamit ang library ng Mga Kahilingan. Ang HTML tree ay ipapa-parse at i-extract gamit BeautifulSoup, at maaaring ayusin ang data gamit lamang ang Python.

Laging ipinapayong suriin ang patakaran sa katanggap-tanggap na paggamit ng iyong target na website upang makita kung ang pag-access sa website gamit ang mga automated na tool ay isang paglabag sa mga kundisyon ng paggamit nito bago gamitin ang iyong mga talento sa Python para sa web scraping.

Paano gumagana ang web scraping?

Ang mga gagamba ay karaniwang ginagamit sa online kudkod proseso. Kinukuha nila ang mga HTML na dokumento mula sa mga nauugnay na website, kinukuha ang kinakailangang nilalaman batay sa lohika ng negosyo, at pagkatapos ay iimbak ito sa isang tiyak na format.

Ang website na ito ay nagsisilbing gabay para sa paglikha ng mataas na nasusukat na mga scrapper.

Ang mga balangkas at diskarte ng Python na sinamahan ng ilang mga snippet ng code ay maaaring gamitin upang mag-scrape ng data sa ilang simpleng paraan. Mayroong ilang mga gabay na magagamit na maaaring makatulong sa iyo na isabuhay ang pareho.

Ang pag-scrape ng isang pahina ay simple, ngunit ang pamamahala sa spider code, pangangalap ng data, at pangangalaga ng isang data warehouse ay mahirap kapag nag-scrap ng milyun-milyong pahina. Upang gawing simple at tumpak ang pag-scrape, susuriin namin ang mga problemang ito at ang kanilang mga pag-aayos.

Mabilis na mga link:

**Karagdagang Tip: Gumamit ng mga umiikot na IP at Proxy Services

Dahil malinaw mong nakuha ang larawan, ang web scraping ay nagbibigay-daan sa iyo na mangalap ng impormasyon mula sa web gamit ang isang set ng mga programming command. Ngunit tulad ng dapat mong malaman, ang iyong mga aktibidad sa pag-scrape sa web ay maaaring masubaybayan sa pamamagitan ng iyong IP address.

Hindi ito magiging malaking isyu kung ang data ay kinukuskos mo ito mula sa isang pampublikong domain. Ngunit kung ikaw ay nag-scrap ng pribadong data mula sa say, isang espesyal na site ng media, maaari kang mapunta sa problema kung ang iyong IP address ay sinusubaybayan.

Kaya, karaniwang, upang maiwasan ang iyong spider na ma-blacklist, palaging mas mainam na gumamit ng mga serbisyo ng proxy at baguhin ang mga IP address.

Hindi ka namin hinihikayat na gumamit ng web scraping para sa pangangalap ng anumang iligal o pribadong data, o pagpapasasa sa ilang mga nakakahamak na aktibidad ng spyware?

Ngunit kung ikaw ay nangangalap ng data na maaaring pribado, inirerekumenda na i-mask o i-rotate ang iyong IP address o gumamit ng proxy server para maiwasang ma-trace.

Maaari mo ring basahin ang:

Legal ba ang web scraping?

Opisyal, wala saanman nakasaad sa mga pamantayan at alituntunin sa internet na ang pag-scrape ng web ay ilegal. Sa lahat ng bagay, ang pag-scrape sa web ay ganap na legal na gawin, basta't ikaw ay gumagawa sa pampublikong data.

Noong huling bahagi ng Enero 2020, inanunsyo na ganap na pinapayagan ang pag-scrap ng data na available sa publiko para sa mga hindi pangkomersyal na layunin.

Ang impormasyon na malayang naa-access sa pangkalahatang publiko ay ang data na naa-access ng lahat online nang walang password o iba pang pagpapatunay. Kaya, ang impormasyon na magagamit sa publiko ay kasama ang maaaring matagpuan sa Wikipedia, social media, o paghahanap sa Google resulta.

Gayunpaman, ang ilang mga website ay tahasang nagbabawal sa mga user na i-scrap ang kanilang data gamit ang web scraping. Ang pag-scrape ng data mula sa social media ay minsan ay itinuturing na ilegal.

Ang dahilan nito ay ang ilan sa mga ito ay hindi naa-access sa pangkalahatang publiko, tulad ng kapag ginawa ng isang user na pribado ang kanilang impormasyon. Sa pagkakataong ito, ipinagbabawal ang pag-scrap ng impormasyong ito. Ang pag-scrape ng impormasyon mula sa mga website nang walang pahintulot ng may-ari ay maaari ding ituring na nakakapinsala.

Kunin ang pinakamahusay sa web sa pamamagitan ng Web Scraping!

Ang pagkolekta at pagsusuri ng data mula sa mga website ay may malawak na potensyal na aplikasyon sa malawak na hanay ng mga larangan, kabilang ang data science, corporate intelligence, at pag-uulat sa pagsisiyasat.

Ang isa sa mga pangunahing kakayahan na kailangan ng data scientist ay ang web scraping.

Tandaan na hindi lahat ay gugustuhin mong i-access ang kanilang mga web server para sa data. Bago simulan ang pag-scrape ng isang website, tiyaking nabasa mo ang Mga Kundisyon ng Paggamit. Gayundin, maging maalalahanin kapag nagtiyempo ng iyong mga query sa web upang maiwasan ang labis na pagkahumaling sa isang server.

Quick Links

- Pinakamahusay na Proxies Para sa Pagsasama-sama ng Pamasahe sa Paglalakbay

- Pinakamahusay na French Proxies

- Pinakamahusay na Tripadvisor Proxies

- Pinakamahusay na Etsy Proxies

- IPRoyal Code ng Kupon

- Pinakamahusay na TikTok Proxies

- Pinakamahusay na Nakabahaging Proxies

- Pinakamahusay na Proxies ng Germany