Найбільше у світі джерело інформації, ймовірно, знаходиться в Інтернеті. Збір і аналіз даних із веб-сайтів має величезний потенціал застосування в багатьох галузях, включаючи науку про дані, корпоративну розвідку та журналістські розслідування.

Науковці даних постійно шукають нову інформацію та дані для модифікації та аналізу. Пошук конкретної інформації в Інтернеті зараз є одним із найпопулярніших методів.

Чи готові ви до свого першого досвіду веб-збирання? Але спочатку ви повинні зрозуміти, що таке веб-скрапінг насправді та деякі його основи, а потім ми поговоримо про найкращі методи веб-скрапінгу.

Що таке веб-скрейпінг?

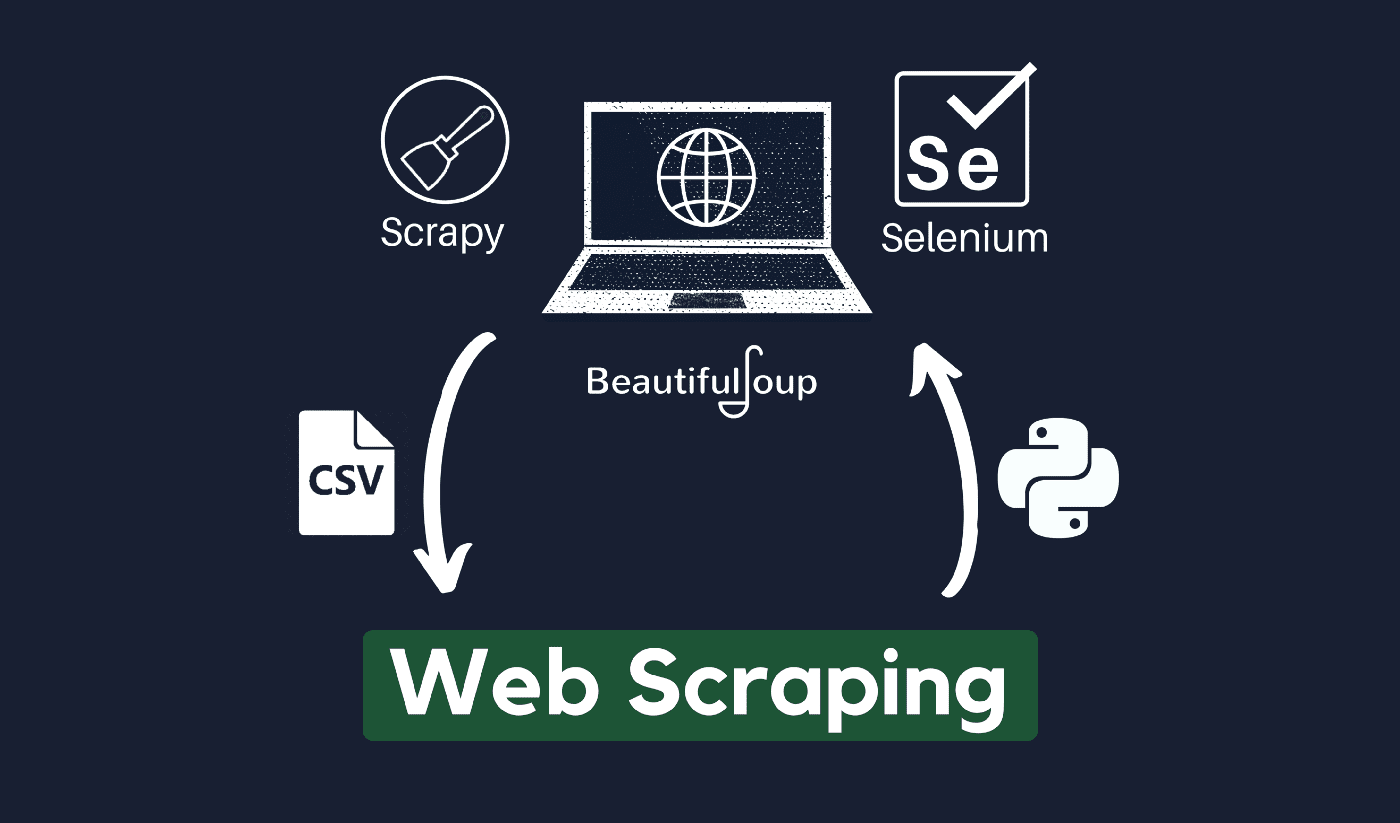

Техніка збору та обробки необроблених даних з Інтернету відома як веб-скрапінг, і спільнота Python розробила кілька досить потужних інструментів веб-скрапінгу. А конвеєр даних використовується для обробки та зберігання цих даних структурованим способом.

Веб-скопіювання сьогодні є звичайною практикою з численними додатками:

- Підприємства з маркетингу та продажів можуть збирати дані, пов’язані з потенційними клієнтами, за допомогою веб-збирання.

- Компанії з нерухомості можуть отримувати інформацію про нові розробки, об’єкти для продажу тощо за допомогою веб-збирання.

- Веб-сайти для порівняння цін, як-от Trivago, часто використовують веб-збирання, щоб отримати дані про продукти та ціни з різних веб-сайтів електронної комерції.

Ви можете скребти павутину за допомогою різноманітних мови програмування, і кожна мова програмування має різноманітні бібліотеки, які можуть допомогти вам виконати те саме. Однією з найпопулярніших, надійних і законних програм, які використовуються для ефективного сканування веб-сторінок, є Python.

Про Python

Python — найпопулярніша мова для копіювання, розроблена та запущена в 1991 році. Ця мова програмування часто використовується для створення веб-сайтів, написання коду, створення програмного забезпечення, створення системних сценаріїв тощо. Програма є наріжним каменем онлайн-сектору та широко використовується в торгівлі по всьому світу.

Веб-програми можна розробляти на сервері за допомогою Python. Його можна використовувати в поєднанні з програмами для побудови процесів і зв’язку з системами баз даних. Він також може читати та змінювати файли.

Його також можна використовувати для керування масивними даними, виконання складних математичних операцій, прискорення процесу створення прототипу або створення програмного забезпечення, готового до виробництва.

Як ви можете використовувати Python для веб-збирання?

Ймовірно, вам потрібно буде пройти три кроки, щоб отримати будь-яку інформацію з Інтернету: отримати HTML, отримати дерево HTML і, нарешті, отримати інформацію з дерева.

Можна отримати HTML-код із певного сайту за допомогою бібліотеки запитів. Потім дерево HTML буде проаналізовано та видобуто за допомогою BeautifulSoup, а потім дані можуть бути організовані лише за допомогою Python.

Завжди бажано перевіряти політику прийнятного використання цільового веб-сайту, щоб перевірити, чи доступ до веб-сайту за допомогою автоматизованих інструментів не є порушенням умов його використання, перш ніж використовувати ваші таланти Python для веб-скрапінгу.

Як працює веб-скрапінг?

Павуки зазвичай використовуються в Інтернеті вишкрібання процес. Вони отримують HTML-документи з відповідних веб-сайтів, витягують необхідний вміст на основі бізнес-логіки, а потім зберігають його в певному форматі.

Цей веб-сайт служить посібником для створення високомасштабованих скрапперів.

Фреймворки та підходи Python у поєднанні з кількома фрагментами коду можна використовувати для збирання даних кількома простими способами. Є кілька доступних посібників, які можуть допомогти вам застосувати те саме на практиці.

Очистити одну сторінку просто, але керувати павуковим кодом, збирати дані та підтримувати сховище даних складно, коли збирають мільйони сторінок. Щоб зробити сканування простим і точним, ми розглянемо ці проблеми та їх вирішення.

Швидкі посилання:

**Додаткова порада: використовуйте чергування IP-адрес і проксі-сервісів

Як ви чітко зрозуміли, веб-скрапінг дозволяє збирати інформацію з Інтернету за допомогою набору програмних команд. Але, як ви маєте знати, вашу діяльність з веб-збирання можна відстежити через вашу IP-адресу.

Це не буде особливою проблемою, якщо дані, які ви збираєте, є загальнодоступними. Але якщо ви знімаєте особисті дані, скажімо, зі спеціального медіа-сайту, у вас можуть виникнути проблеми, якщо вашу IP-адресу відстежать.

Отже, щоб запобігти потраплянню вашого павука в чорний список, завжди краще використовувати проксі-сервери та змінювати IP-адреси.

Ми ні в якому разі не заохочуємо вас використовувати сканування веб-сторінок для збору будь-яких незаконних чи приватних даних або для виконання зловмисних шпигунських програм?

Але якщо ви збираєте дані, які можуть бути конфіденційними, рекомендується маскувати або обертати ваші IP-адреса або використовуйте проксі-сервер, щоб уникнути відстеження.

Ви також можете прочитати:

Чи законний веб-скрейпінґ?

Офіційно в Інтернет-нормах і рекомендаціях ніде не вказано, що веб-збирання є незаконним. Чесно кажучи, веб-збирання є абсолютно законним, якщо ви працюєте з загальнодоступними даними.

Наприкінці січня 2020 року було оголошено, що збирати загальнодоступні дані для некомерційних цілей цілком дозволено.

Інформація, яка є у вільному доступі для широкого загалу, — це дані, доступні кожному в Інтернеті без пароля чи іншої автентифікації. Отже, інформація, яка є загальнодоступною, включає інформацію, яку можна знайти у Вікіпедії, соціальних мережах або Пошук в Google результати.

Однак деякі веб-сайти прямо забороняють користувачам очищати свої дані за допомогою веб-збирання. Збирання даних із соціальних мереж іноді вважається незаконним.

Причина цього полягає в тому, що деякі з них недоступні для широкого загалу, наприклад, коли користувач робить свою інформацію приватною. У цьому випадку копіювання цієї інформації заборонено. Збирання інформації з веб-сайтів без згоди власника також може вважатися шкідливим.

Отримайте найкраще від Інтернету за допомогою Web Scraping!

Збір і аналіз даних із веб-сайтів має величезний потенціал застосування в багатьох галузях, включаючи науку про дані, корпоративну розвідку та журналістські розслідування.

Однією з основних навичок, необхідних спеціалісту з обробки даних, є аналіз веб-сторінок.

Майте на увазі, що не всі хочуть, щоб ви отримували доступ до їхніх веб-серверів для отримання даних. Перш ніж розпочати сканування веб-сайту, переконайтеся, що ви прочитали Умови використання. Крім того, будьте уважними під час виконання веб-запитів, щоб уникнути перевантаження сервера.

Швидкі посилання