Pengikisan online memungkinkan Anda mengumpulkan data terbuka dari situs web untuk tujuan seperti perbandingan harga, riset pasar, verifikasi iklan, dll.

Sejumlah besar data publik yang diperlukan biasanya diekstraksi, tetapi ketika Anda menghadapi blokade, ekstraksi mungkin menjadi tantangan.

Pembatasan dapat berupa pemblokiran tarif atau pemblokiran IP (alamat IP permintaan dibatasi karena berasal dari area terlarang, jenis IP terlarang, dll). (alamat IP diblokir karena telah membuat banyak permintaan).

Sekarang jika Anda siap untuk mengorek beberapa pengetahuan dan informasi yang berguna, maka saya yakin Anda pasti mempertimbangkan untuk mengorek Wikipedia, ensiklopedia pengetahuan yang menyimpan banyak informasi.

Mari kita pahami beberapa hal tentang web scraping Wikipedia.

Pengikisan Web Wikipedia

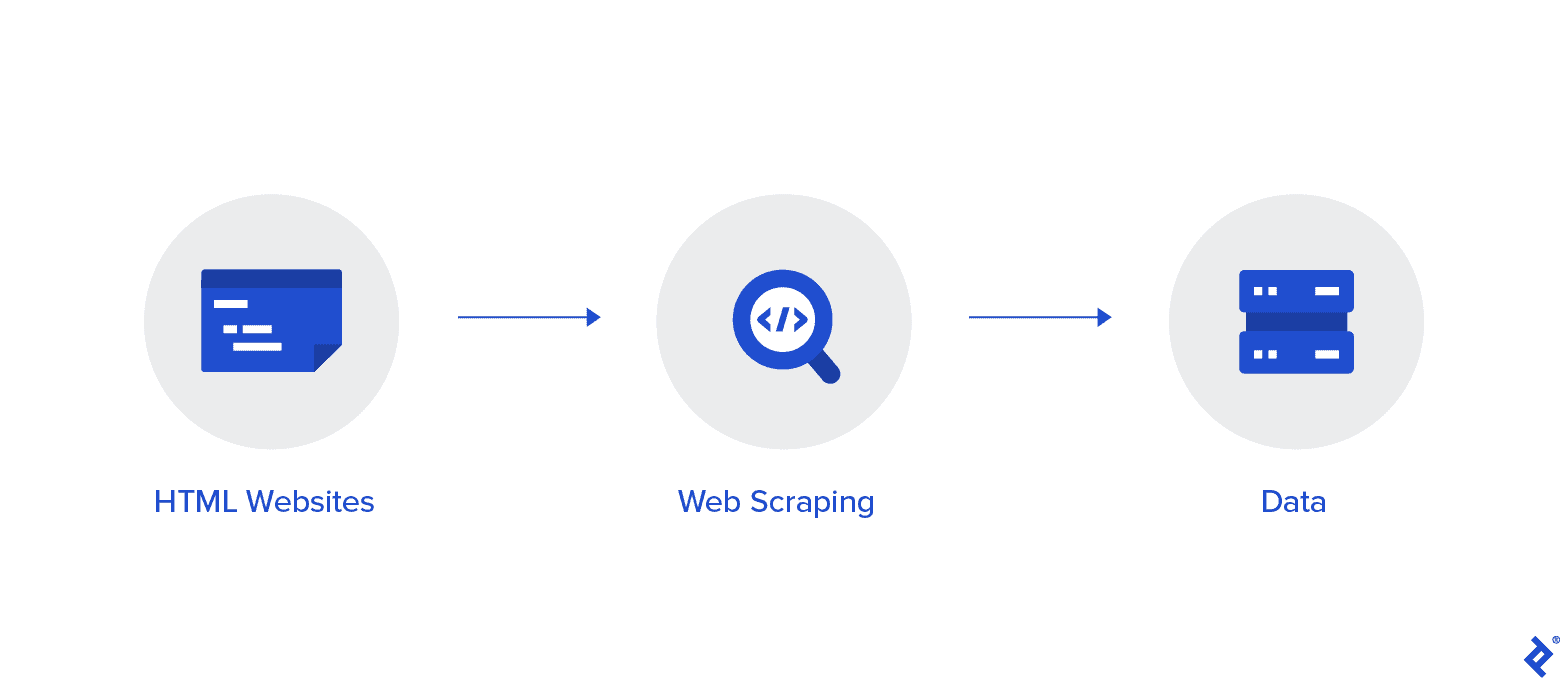

Pengikisan web adalah metode otomatis untuk mengumpulkan data dari internet. Informasi mendalam tentang pengikisan web, perbandingan dengan perayapan web, dan argumen yang mendukung pengikisan web disediakan dalam artikel ini.

Tujuannya adalah untuk mengumpulkan data dari halaman Beranda Wikipedia menggunakan berbagai metode pengikisan web, lalu menguraikannya.

Anda akan menjadi lebih akrab dengan berbagai metode pengikisan web, pustaka pengikisan web Python, dan prosedur ekstraksi dan pemrosesan data.

Pengikisan Web dan Python

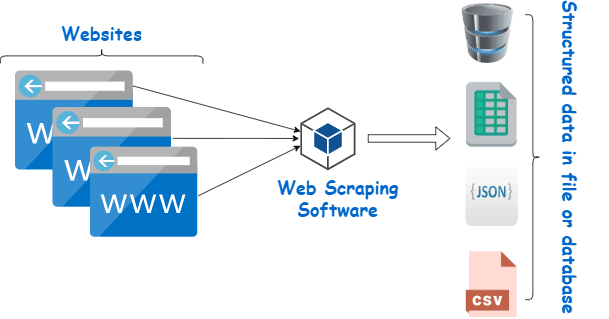

Pengikisan web pada dasarnya adalah proses mengekstraksi data terstruktur dari sejumlah besar data dari sejumlah besar situs web menggunakan perangkat lunak yang dibuat dalam bahasa pemrograman dan menyimpannya secara lokal di perangkat kami, sebaiknya dalam lembar Excel, JSON, atau spreadsheet.

Ini membantu pemrogram dalam membuat kode yang logis dan mudah dipahami baik untuk proyek kecil maupun besar.

Python terutama dianggap sebagai bahasa terbaik untuk pengikisan web. Ini dapat secara efektif menangani sebagian besar tugas yang berhubungan dengan perayapan web dan lebih menyeluruh.

Bagaimana cara mengikis data dari Wikipedia?

Data dapat diekstraksi dari halaman web dengan berbagai cara.

Misalnya, Anda dapat menerapkannya sendiri menggunakan bahasa komputer seperti Piton. Namun, kecuali Anda paham teknologi, Anda perlu banyak belajar sebelum dapat melakukan banyak hal dengan proses ini.

Ini juga memakan waktu dan mungkin memakan waktu selama menyisir halaman Wikipedia secara manual. Selain itu, pengikis web gratis dapat diakses secara online. Namun, mereka sering kurang dapat diandalkan, dan pemasok mereka mungkin memiliki niat yang tidak baik.

Berinvestasi dalam pengikis web yang layak dari pemasok terkemuka adalah metode terbaik untuk mengumpulkan data Wiki.

Langkah selanjutnya biasanya sederhana dan tidak rumit karena penyedia akan memberi Anda petunjuk tentang cara memasang dan menggunakan pengikis.

Proksi adalah alat yang dapat Anda gunakan bersama dengan pengikis wiki Anda untuk mengikis data dengan lebih efektif. Framework berbasis Python seperti Scrapy, Menggores Robot, dan Beautiful Soup hanyalah beberapa contoh betapa mudahnya mengikis menggunakan bahasa ini.

Proksi untuk Mengikis data dari Wikipedia

Anda memerlukan proxy yang sangat cepat, aman digunakan, dan dijamin tidak akan menimpa Anda saat Anda membutuhkannya untuk mengikis data secara efektif. Proksi semacam itu tersedia dari Rayobyte dengan harga yang wajar.

Kami berusaha untuk menawarkan berbagai proxy karena kami menyadari bahwa setiap pengguna memiliki preferensi dan kasus penggunaan yang berbeda.

Memutar proxy untuk pengikisan web Wikipedia

Contoh dari proxy adalah salah satu yang merotasi alamat IP-nya secara teratur. Selain itu, untuk mencegah gangguan, alamat IP segera diubah saat terjadi pelarangan. Ini menjadikan proxy khusus ini pilihan yang bagus untuk pengikisan situs.

Proksi statis, sebagai perbandingan, hanya memiliki satu alamat IP. Jika ISP Anda tidak mengaktifkan penggantian otomatis, Anda akan menemui jalan buntu jika Anda hanya memiliki akses ke satu alamat IP dan alamat itu diblokir. Karena itu, proxy statis bukanlah pilihan terbaik untuk pengikisan web.

Proksi residensial untuk web scraping data Wiki

Proksi perumahan adalah alamat IP proksi yang didistribusikan oleh Penyedia Layanan Internet (ISP) dan dikaitkan dengan rumah tangga tertentu. Karena berasal dari orang sungguhan, mendapatkannya cukup menantang. Akibatnya, mereka langka dan relatif mahal.

Saat Anda menggunakan proxy tempat tinggal untuk mengikis data, Anda tampak seperti pengguna biasa karena mereka terhubung ke alamat individu yang sebenarnya.

Jadi, menggunakan proxy perumahan secara signifikan mengurangi peluang Anda untuk ditemukan dan diblokir. Oleh karena itu, mereka adalah kandidat yang sangat baik untuk mengorek data.

Memutar proxy tempat tinggal untuk mengumpulkan data wiki

Proksi perumahan berputar, yang menggabungkan dua jenis yang baru saja kita bicarakan, adalah proksi terbaik untuk pengikisan web Wikipedia.

Anda dapat mengakses sejumlah besar IP rumah menggunakan proxy yang sering merotasinya.

Ini penting karena, meskipun sulit mengidentifikasi proxy tempat tinggal, volume permintaan yang mereka hasilkan pada akhirnya akan menarik perhatian situs web yang sedang dihapus.

Memutar memastikan proyek dapat berjalan meskipun alamat IP mau tidak mau masuk daftar hitam.

Oleh karena itu, kami memiliki apa yang Anda butuhkan, apakah Anda memutuskan untuk menggunakan beberapa proxy pusat data atau Anda lebih memilih untuk berinvestasi di beberapa proxy perumahan.

Anda akan menikmati pengalaman pengikisan web terbaik dengan proxy yang berjalan pada kecepatan 1GBS, lebar pita tidak terbatas, dan bantuan pelanggan sepanjang waktu.

Anda juga bisa membaca

- Teknik Scraping Web Terbaik: Panduan Praktis

- Tinjauan Octoparse Apakah Alat Scraping Web Ini Sangat Bagus?

- Alat Scraping Web Terbaik

- Apa itu Scraping Web? - Bagaimana Ini Digunakan? Bagaimana Ini Dapat Menguntungkan Bisnis Anda

Mengapa Anda harus mengikis Wikipedia?

Wikipedia adalah salah satu layanan paling tepercaya dan kaya informasi di dunia online saat ini. Ada jawaban dan informasi untuk hampir semua jenis topik yang dapat Anda pikirkan di platform ini.

Jadi, tentu saja, Wikipedia adalah sumber yang bagus untuk mengorek data. Mari kita bahas alasan utama mengapa Anda harus mengikis Wikipedia.

Pengikisan web untuk penelitian akademik

Pengumpulan data adalah salah satu kegiatan paling menyakitkan yang terlibat dalam penelitian. Seperti yang sudah dibahas, web scraper membuat prosedur ini lebih cepat dan mudah sekaligus menghemat banyak waktu dan energi Anda.

Dengan pengikis web, Anda dapat dengan cepat memindai banyak halaman wiki dan mengumpulkan semua data yang Anda perlukan secara terorganisir.

Asumsikan sejenak bahwa tujuan Anda adalah untuk menentukan apakah depresi dan paparan sinar matahari berbeda di setiap negara.

Anda dapat menggunakan pengikis Wiki untuk menemukan informasi seperti prevalensi depresi di berbagai negara dan jam-jam cerahnya alih-alih melalui banyak entri Wikipedia.

Manajemen reputasi

Membuat halaman Wikipedia sudah menjadi strategi pemasaran yang wajib dilakukan untuk berbagai jenis bisnis di era modern karena postingan Wikipedia sering muncul di halaman pertama Google.

Namun, memiliki halaman di Wikipedia seharusnya tidak menjadi akhir dari upaya pemasaran Anda. Wikipedia adalah platform yang bersumber dari banyak orang, jadi vandalisme adalah sesuatu yang cukup sering terjadi.

Akibatnya, seseorang dapat menambahkan informasi yang tidak menyenangkan ke halaman perusahaan Anda dan merusak reputasi Anda. Alternatifnya, mereka mungkin mencemarkan nama baik bisnis Anda di artikel wiki yang relevan.

Karena itu, Anda harus mengawasi halaman Wiki Anda serta halaman lain yang menyebutkan bisnis Anda setelah dibuat. Anda dapat melakukannya dengan bantuan pengikis wiki dengan mudah.

Anda dapat menelusuri halaman Wikipedia secara berkala untuk referensi bisnis Anda dan menunjukkan setiap contoh vandalisme di sana.

Tingkatkan SEO

Anda dapat memanfaatkan Wikipedia untuk meningkatkan lalu lintas ke situs web Anda.

Buat daftar artikel yang ingin Anda ubah dengan menggunakan pengikis data Wiki untuk menemukan halaman yang berkaitan dengan bisnis Anda dan audiens target Anda.

Mulailah dengan membaca artikel dan membuat beberapa penyesuaian yang berguna untuk mendapatkan kredibilitas sebagai kontributor situs.

Setelah Anda membangun kredibilitas, Anda dapat menambahkan tautan ke situs web Anda di tempat-tempat di mana ada tautan yang rusak atau di mana kutipan diperlukan.

Link cepat

Pustaka Python digunakan untuk pengikisan web

Python adalah bahasa pemrograman dan alat pengikis web paling populer dan terkemuka di dunia, seperti yang telah dikatakan. Sekarang mari kita lihat pustaka pengikisan web Python yang tersedia saat ini.

Pustaka Permintaan (HTTP untuk Manusia) untuk Pengikisan Web

Ini digunakan untuk mengirim permintaan HTTP yang berbeda, seperti GET dan POST. Di antara semua perpustakaan, ini adalah yang paling mendasar tetapi juga yang paling penting.

Perpustakaan lxml untuk Pengikisan Web

Penguraian teks HTML dan XML yang sangat cepat dan berkinerja tinggi dari situs web ditawarkan oleh paket lxml. Ini yang harus dipilih jika Anda berniat untuk mengikis database besar.

Perpustakaan Sup Cantik untuk Pengikisan Web

Pekerjaannya adalah membangun pohon parse untuk penguraian konten. Tempat yang bagus untuk memulai bagi pemula dan sangat ramah pengguna.

Perpustakaan Selenium untuk Pengikisan Web

Pustaka ini memecahkan masalah yang dimiliki semua pustaka yang disebutkan di atas, yaitu menggores konten dari halaman web yang diisi secara dinamis.

Awalnya dirancang untuk pengujian otomatis aplikasi web. Karena itu, ini lebih lambat dan tidak sesuai untuk tugas di tingkat industri.

Scrapy untuk Pengikisan Web

Kerangka pengikisan web lengkap itu menggunakan penggunaan asinkron adalah BOSS dari semua paket. Ini meningkatkan efisiensi dan membuatnya sangat cepat.

Kesimpulan

Jadi ini adalah aspek terpenting yang perlu Anda ketahui tentang Wikipedia Web Scraping. Nantikan bersama kami untuk postingan informatif lainnya di Web Scraping dan banyak lagi lainnya!

tautan langsung