Lo scraping online consente di raccogliere dati aperti da siti Web per scopi quali confronto dei prezzi, ricerche di mercato, verifica degli annunci, ecc.

In genere vengono estratte grandi quantità di dati pubblici necessari, ma quando si incontrano blocchi, l'estrazione potrebbe diventare impegnativa.

La restrizione può essere il blocco della velocità o il blocco dell'IP (l'indirizzo IP della richiesta è limitato perché proviene da un'area proibita, da un tipo di IP proibito e così via). (l'indirizzo IP è bloccato perché ha effettuato più richieste).

Ora, se sei pronto per raschiare alcune conoscenze e informazioni utili, allora sono sicuro che devi aver preso in considerazione l'idea di raschiare Wikipedia, l'enciclopedia della conoscenza che ospita tonnellate di informazioni.

Comprendiamo alcune cose sul web scraping di Wikipedia.

Scraping web di Wikipedia

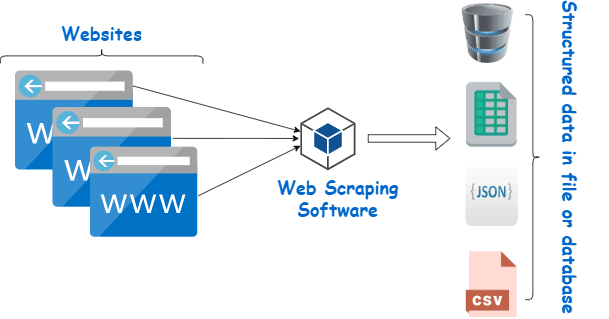

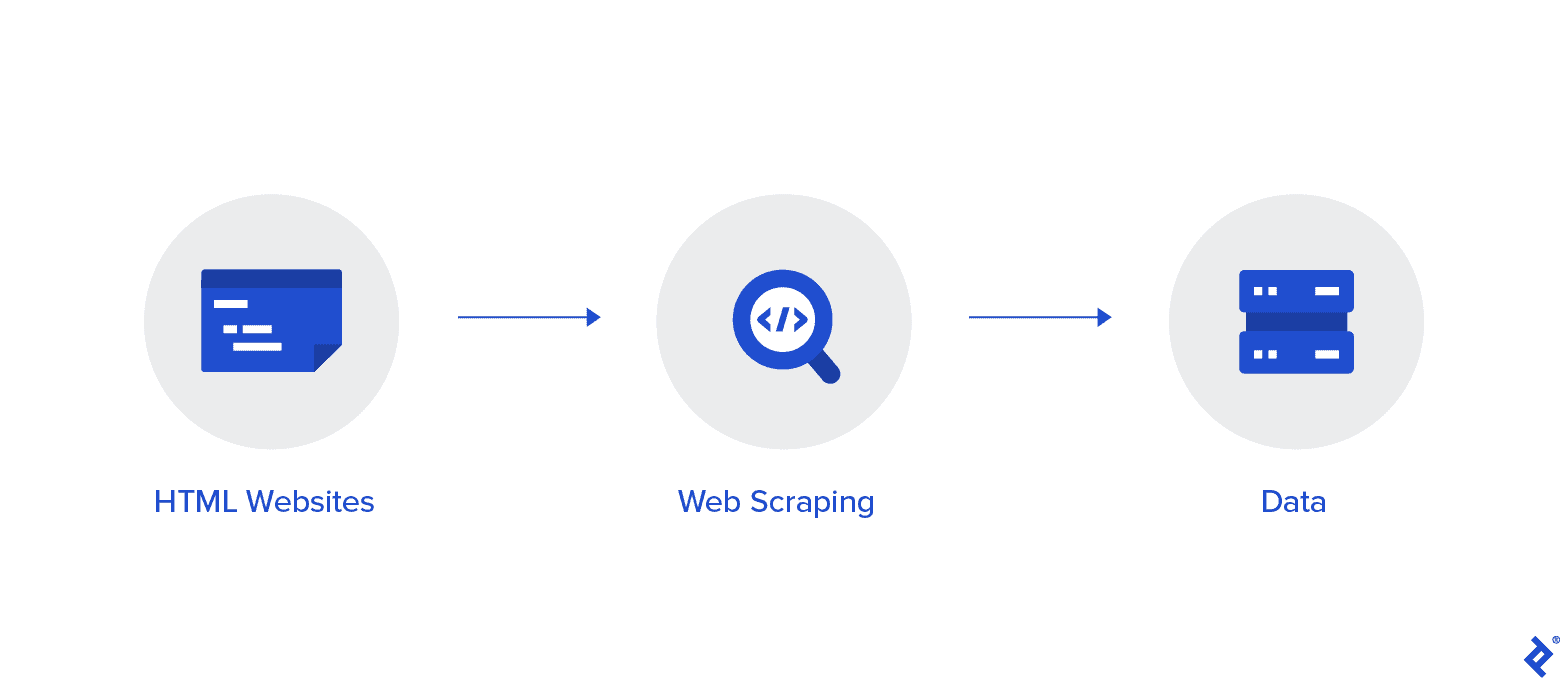

Il web scraping è un metodo automatizzato per raccogliere dati da Internet. In questo articolo vengono fornite informazioni approfondite sul web scraping, un confronto con il web crawling e argomenti a favore del web scraping.

L'obiettivo è raccogliere dati dalla home page di Wikipedia utilizzando vari metodi di web scraping, quindi analizzarli.

Acquisirai maggiore familiarità con vari metodi di web scraping, librerie di web scraping Python e procedure di estrazione ed elaborazione dei dati.

Scraping Web e Python

Il web scraping è essenzialmente il processo di estrazione di dati strutturati da una grande quantità di dati da un gran numero di siti Web utilizzando un software creato in un linguaggio di programmazione e salvandolo localmente sui nostri dispositivi, preferibilmente in fogli Excel, JSON o fogli di calcolo.

Questo aiuta i programmatori a creare codice logico e comprensibile per progetti piccoli e grandi.

Python è principalmente considerato il miglior linguaggio per il web scraping. Può gestire efficacemente la maggior parte delle attività relative alla scansione del Web ed è più un tuttofare.

Come raschiare i dati da Wikipedia?

I dati possono essere estratti dalle pagine web in vari modi.

Ad esempio, puoi implementarlo tu stesso usando linguaggi informatici come Python. Ma, a meno che tu non sia esperto di tecnologia, dovrai studiare molto prima di poter fare molto con questo processo.

È anche dispendioso in termini di tempo e potrebbe richiedere tanto tempo quanto la pettinatura manuale delle pagine di Wikipedia. Inoltre, i web scraper gratuiti sono accessibili online. Tuttavia, spesso mancano di affidabilità e i loro fornitori possono avere intenzioni losche.

Investire in un web scraper decente da un fornitore affidabile è il metodo migliore per raccogliere dati Wiki.

Il passaggio successivo è solitamente semplice e senza complicazioni perché il provider ti offrirà le istruzioni su come installare e utilizzare il raschietto.

Un proxy è uno strumento che puoi utilizzare insieme al tuo raschietto wiki per raschiare i dati in modo più efficace. Framework basati su Python come Scrapy, Robot raschiantee Beautiful Soup sono solo alcuni esempi di quanto sia facile raschiare usando questo linguaggio.

Proxy per raschiare i dati da Wikipedia

Hai bisogno di proxy che siano estremamente veloci, sicuri da usare e che garantiscano che non ti abbattano quando ne hai bisogno per raschiare i dati in modo efficace. Tali proxy sono disponibili da Rayobyte a prezzi ragionevoli.

Facciamo uno sforzo per offrire una varietà di proxy perché siamo consapevoli che ogni utente ha preferenze e casi d'uso diversi.

Proxy rotanti per il web scraping di Wikipedia

Un'istanza di un proxy è quella che ruota regolarmente il proprio indirizzo IP. Inoltre, per evitare interruzioni, l'indirizzo IP viene modificato immediatamente quando si verifica un divieto. Ciò rende questo particolare proxy un'ottima scelta per lo scraping del sito.

I proxy statici, in confronto, hanno un solo indirizzo IP. Se il tuo ISP non abilita le sostituzioni automatiche, ti imbatterai in un muro di mattoni se hai accesso a un solo indirizzo IP e viene bloccato. Per questo motivo, i proxy statici non sono l'opzione migliore per il web scraping.

Proxy residenziali per il web scraping dei dati Wiki

I proxy residenziali sono indirizzi IP proxy che i provider di servizi Internet (ISP) distribuiscono e sono associati a famiglie specifiche. Poiché provengono da persone reali, ottenerli è piuttosto impegnativo. Di conseguenza, sono scarsi e relativamente costosi.

Quando utilizzi i proxy residenziali per raschiare i dati, sembri un utente comune perché sono collegati agli indirizzi di persone reali.

Pertanto, l'utilizzo di proxy residenziali riduce significativamente la possibilità di essere scoperti e bloccati. Sono quindi ottimi candidati per lo scraping dei dati.

Proxy residenziali a rotazione per la raccolta di dati wiki

Un proxy residenziale rotante, che combina i due tipi di cui abbiamo appena parlato, è il miglior proxy per il web scraping di Wikipedia.

Puoi accedere a un gran numero di IP domestici utilizzando un proxy che li ruota frequentemente.

Questo è fondamentale perché, nonostante la difficoltà nell'identificare i proxy residenziali, il volume di richieste che generano alla fine attirerà l'attenzione del sito web che viene cancellato.

La rotazione assicura che il progetto possa andare avanti anche se l'indirizzo IP viene inevitabilmente inserito nella lista nera.

Pertanto, abbiamo ciò di cui hai bisogno, sia che tu decida di utilizzare diversi proxy per data center o che tu preferisca investire in alcuni proxy residenziali.

Godrai della migliore esperienza di web scraping con proxy in esecuzione a una velocità di 1 GBS, larghezza di banda illimitata e assistenza clienti XNUMX ore su XNUMX.

Puoi anche leggere

- Le migliori tecniche di web scraping: una guida pratica

- Recensione di Octoparse È davvero un buon strumento di web scraping?

- I migliori strumenti di web scraping

- Che cos'è il web scraping? - Come viene utilizzato? Come può avvantaggiare la tua attività

Perché dovresti raschiare Wikipedia?

Wikipedia è uno dei servizi più affidabili e ricchi di informazioni nel mondo online in questo momento. Ci sono risposte e informazioni su quasi tutti i tipi di argomenti a cui puoi pensare su questa piattaforma.

Quindi, naturalmente, Wikipedia è un'ottima fonte da cui ricavare dati. Cerchiamo di discutere i motivi principali per cui dovresti raschiare Wikipedia.

Scraping Web per la ricerca accademica

La raccolta dei dati è una delle attività più dolorose coinvolte nella ricerca. Come già discusso, i web scraper rendono questa procedura più rapida e semplice, risparmiando anche un sacco di tempo ed energia.

Con un web scraper, puoi scansionare rapidamente numerose pagine wiki e raccogliere tutti i dati richiesti in modo organizzato.

Supponiamo per un momento che il tuo obiettivo sia determinare se la depressione e l'esposizione alla luce solare variano in base al paese.

Puoi utilizzare un Wiki scraper per individuare informazioni come la prevalenza della depressione in diverse nazioni e le loro ore di sole invece di passare attraverso numerose voci di Wikipedia.

Gestione della reputazione

Creare una pagina di Wikipedia è diventata una strategia di marketing indispensabile per molti diversi tipi di attività nell'era moderna perché i post di Wikipedia appaiono spesso sulla prima pagina di Google.

Ma avere una pagina su Wikipedia non dovrebbe essere la fine dei tuoi sforzi di marketing. Wikipedia è un piattaforma di crowdfunding, quindi il vandalismo è qualcosa che accade piuttosto frequentemente.

Di conseguenza, qualcuno potrebbe aggiungere informazioni sfavorevoli alla pagina della tua azienda e danneggiare la tua reputazione. In alternativa, potrebbero diffamare la tua attività in un articolo wiki pertinente.

Per questo motivo, devi tenere d'occhio la tua pagina Wiki e altre pagine che menzionano la tua attività una volta che è stata creata. Puoi farlo facilmente con l'aiuto di un raschietto wiki.

Puoi periodicamente cercare nelle pagine di Wikipedia riferimenti alla tua attività e segnalare eventuali casi di vandalismo.

Potenzia la SEO

Puoi utilizzare Wikipedia per aumentare il traffico verso il tuo sito web.

Crea un elenco di articoli che desideri modificare utilizzando uno scraper di dati Wiki per individuare le pagine pertinenti alla tua attività e al tuo pubblico di destinazione.

Inizia leggendo gli articoli e apportando alcune modifiche utili per guadagnare credibilità come collaboratore del sito.

Una volta stabilita una certa credibilità, puoi aggiungere collegamenti al tuo sito Web in punti in cui sono presenti collegamenti interrotti o in cui sono richieste citazioni.

Collegamenti rapidi

Librerie Python utilizzate per il web scraping

Python è il linguaggio di programmazione e lo strumento di web scraping più popolare e affidabile al mondo, come già detto. Ora diamo un'occhiata alle librerie di web scraping Python che sono disponibili in questo momento.

Libreria Requests (HTTP for Humans) per il web scraping

Viene utilizzato per inviare diverse richieste HTTP, come GET e POST. Tra tutte le biblioteche è la più fondamentale ma anche la più cruciale.

Libreria lxml per il web scraping

L'analisi molto rapida e ad alte prestazioni del testo HTML e XML dai siti Web è offerta dal pacchetto lxml. Questo è quello da scegliere se intendi raschiare enormi database.

Bella libreria di zuppe per il web scraping

Il suo lavoro è costruire un albero di analisi per l'analisi dei contenuti. Un ottimo punto di partenza per i principianti ed è estremamente intuitivo.

Libreria di selenio per il web scraping

Questa libreria risolve il problema che hanno tutte le librerie sopra menzionate, vale a dire lo scraping di contenuti da pagine Web popolate dinamicamente.

È stato originariamente progettato per il test automatizzato delle applicazioni web. Per questo motivo è più lento e inadatto a compiti a livello industriale.

Scrapy per il web scraping

Un framework di web scraping completo che utilizza l'utilizzo asincrono è il BOSS di tutti i pacchetti. Ciò migliora l'efficienza e lo rende incredibilmente veloce.

Conclusione

Quindi questo era praticamente l'aspetto più importante che devi sapere su Wikipedia Web Scraping. Resta sintonizzato con noi per ulteriori post informativi su Web Scraping e molto altro!

Link Rapidi