Онлайн-скрапинг позволяет собирать открытые данные с веб-сайтов для таких целей, как сравнение цен, исследование рынка, проверка рекламы и т. д.

Обычно извлекаются большие объемы необходимых общедоступных данных, но когда вы сталкиваетесь с блокировками, извлечение может стать затруднительным.

Ограничение может быть либо блокировкой скорости, либо блокировкой IP (IP-адрес запроса ограничен, поскольку он исходит из запрещенной зоны, запрещенного типа IP и т. д.). (IP-адрес заблокирован, потому что он сделал несколько запросов).

Теперь, если вы хотите получить некоторые полезные знания и информацию, то я уверен, что вы, должно быть, подумали о том, чтобы очистить Википедию, энциклопедию знаний, которая является домом для тонны информации.

Давайте разберемся с некоторыми вещами, связанными с парсингом Википедии.

Веб-парсинг Википедии

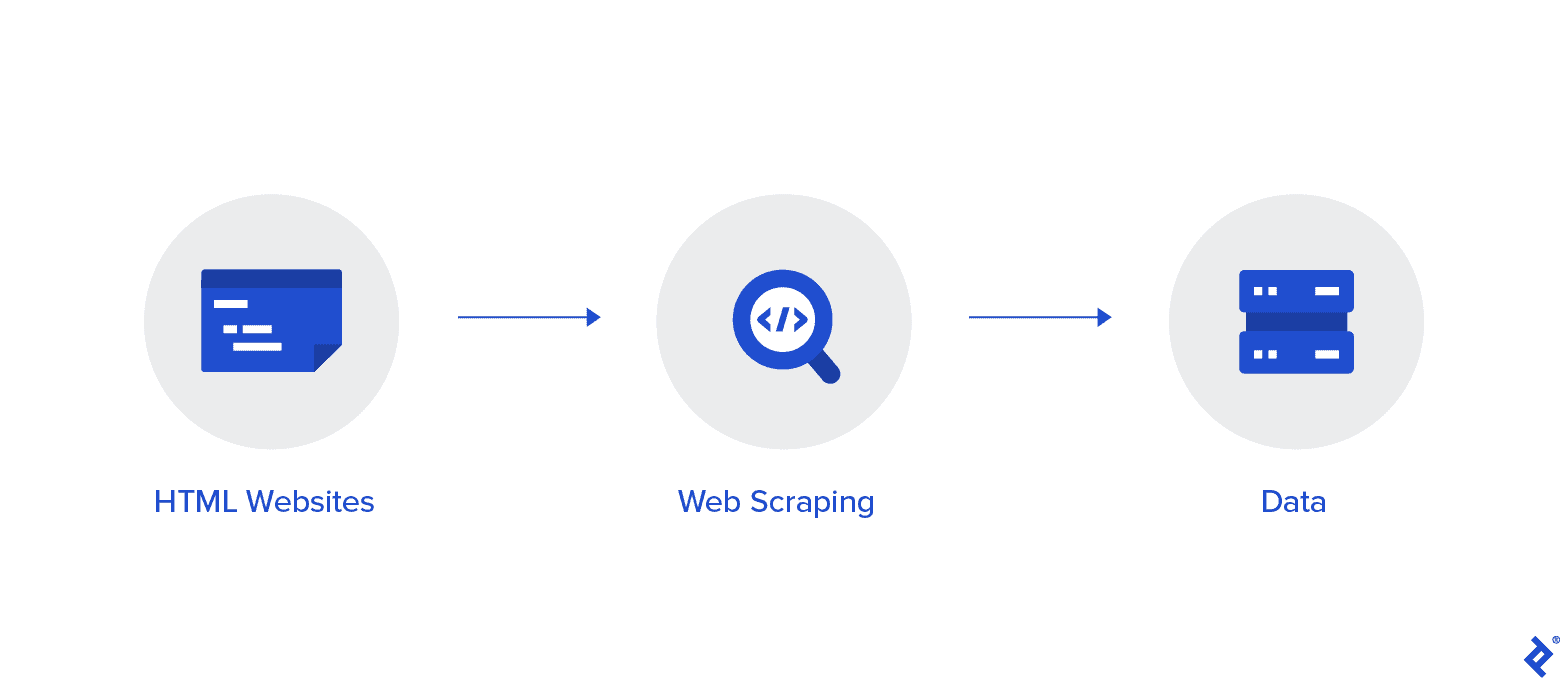

Веб-скрапинг — это автоматизированный метод сбора данных из Интернета. Подробная информация о веб-скрейпинге, сравнение с веб-сканированием и аргументы в пользу веб-скрейпинга представлены в этой статье.

Цель состоит в том, чтобы собрать данные с домашней страницы Википедии, используя различные методы парсинга, а затем проанализировать их.

Вы познакомитесь с различными методами парсинга веб-страниц, библиотеками парсинга веб-страниц Python, а также процедурами извлечения и обработки данных.

Веб-скрейпинг и Python

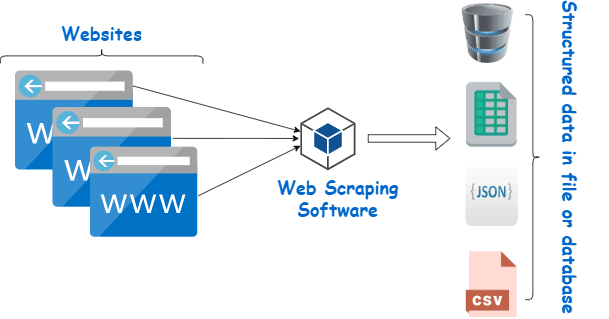

Веб-скрапинг — это, по сути, процесс извлечения структурированных данных из большого количества данных с большого количества веб-сайтов с использованием программного обеспечения, созданного на языке программирования, и сохранения их локально на наших устройствах, предпочтительно в виде таблиц Excel, JSON или электронных таблиц.

Это помогает программистам создавать логичный и понятный код как для небольших, так и для больших проектов.

Python в первую очередь считается лучшим языком для парсинга веб-страниц. Он может эффективно справляться с большинством задач, связанных со сканированием веб-страниц, и является более универсальным.

Как очистить данные из Википедии?

Данные могут быть извлечены из веб-страниц различными способами.

Например, вы можете реализовать это самостоятельно, используя компьютерные языки как Питон. Но, если вы не разбираетесь в технологиях, вам нужно будет много учиться, прежде чем вы сможете что-то сделать с этим процессом.

Это также отнимает много времени и может занять столько же времени, сколько ручное прочесывание страниц Википедии. Более того, бесплатные парсеры доступны онлайн. Тем не менее, им часто не хватает надежности, а их поставщики могут иметь сомнительные намерения.

Инвестирование в приличный веб-скрейпер от известного поставщика — лучший способ собрать данные Wiki.

Следующий шаг обычно прост и несложный, потому что провайдер предложит вам инструкции по установке и использованию парсера.

Прокси — это инструмент, который вы можете использовать вместе с парсером вики для более эффективного сбора данных. Фреймворки на основе Python, такие как Scrapy, Робот-скребок, и Beautiful Soup — это лишь несколько примеров того, как легко парсить с помощью этого языка.

Прокси для очистки данных из Википедии

Вам нужны чрезвычайно быстрые, безопасные в использовании прокси-серверы, которые гарантированно не сломаются, когда они вам понадобятся, чтобы эффективно очищать данные. Такие прокси доступны от Rayobyte по разумной цене.

Мы стараемся предлагать различные прокси, потому что понимаем, что у каждого пользователя разные предпочтения и варианты использования.

Вращающиеся прокси для веб-скрапинга Википедия

Экземпляр прокси — это тот, который регулярно меняет свой IP-адрес. Также во избежание перебоев IP-адрес сразу меняется при наступлении бана. Это делает этот конкретный прокси отличным выбором для парсинга сайтов.

Статические прокси, для сравнения, имеют только один IP-адрес. Если ваш интернет-провайдер не поддерживает автоматическую замену, вы столкнетесь с кирпичной стеной, если у вас есть доступ только к одному IP-адресу, и он будет заблокирован. Из-за этого статические прокси — не лучший вариант для парсинга веб-страниц.

Резидентные прокси для парсинга вики-данных

Резидентные прокси-серверы — это IP-адреса прокси-серверов, которые распределяют интернет-провайдеры (ISP) и которые связаны с конкретными домохозяйствами. Поскольку они исходят от реальных людей, получить их довольно сложно. В результате они дефицитны и относительно дороги.

Когда вы используете резидентные прокси для очистки данных, вы кажетесь обычным пользователем, потому что они связаны с адресами реальных людей.

Таким образом, использование резидентных прокси значительно снижает ваши шансы быть обнаруженным и заблокированным. Поэтому они являются отличными кандидатами для очистки данных.

Ротация резидентных прокси для сбора вики-данных

Вращающийся резидентный прокси, который сочетает в себе два типа, о которых мы только что говорили, является лучшим прокси для парсинга Википедии.

Вы можете получить доступ к большому количеству домашних IP-адресов, используя прокси-сервер, который часто их меняет.

Это очень важно, потому что, несмотря на сложность идентификации резидентных прокси, объем генерируемых ими запросов в конечном итоге привлечет внимание анализируемого веб-сайта.

Ротация гарантирует, что проект может продолжаться, даже если IP-адрес неизбежно попадет в черный список.

Поэтому у нас есть то, что вам нужно, независимо от того, решите ли вы использовать несколько прокси-серверов для центров обработки данных или предпочитаете инвестировать в несколько резидентных прокси-серверов.

Вам понравится лучший опыт парсинга веб-страниц с прокси-серверами, работающими со скоростью 1 ГБ, неограниченной пропускной способностью и круглосуточной поддержкой клиентов.

Вы также можете прочитать

- Лучшие методы парсинга веб-страниц: практическое руководство

- Обзор Octoparse Действительно ли это хороший инструмент для парсинга веб-страниц?

- Лучшие инструменты веб-скрейпинга

- Что такое веб-скрейпинг? - Как он используется? Как это может принести пользу вашему бизнесу

Зачем парсить Википедию?

Википедия сейчас является одним из самых надежных и богатых информацией сервисов в онлайн-мире. На этой платформе есть ответы и информация почти на все темы, о которых вы только можете подумать.

Так что, естественно, Википедия — отличный источник для извлечения данных. Давайте обсудим основные причины, по которым вам следует очистить Википедию.

Веб-скрапинг для академических исследований

Сбор данных — одна из самых болезненных операций, связанных с исследованиями. Как уже говорилось, парсеры делают эту процедуру быстрее и проще, а также экономят массу времени и энергии.

С помощью парсера вы можете быстро просмотреть многочисленные вики-страницы и собрать все необходимые данные в организованном порядке.

Предположим на мгновение, что ваша цель — определить, различаются ли депрессия и подверженность солнечному свету в разных странах.

Вы можете использовать парсер Вики, чтобы найти такую информацию, как распространенность депрессии в разных странах и их солнечные часы, вместо того, чтобы просматривать многочисленные статьи Википедии.

Управление репутацией

Создание страницы в Википедии стало обязательной маркетинговой стратегией для многих различных видов бизнеса в современную эпоху, потому что сообщения Википедии часто появляются на первой странице Google.

Но наличие страницы в Википедии не должно быть концом ваших маркетинговых усилий. Википедия — это краудсорсинговая платформа, так что вандализм - это то, что происходит довольно часто.

В результате кто-то может добавить неблагоприятную информацию на страницу вашей компании и навредить вашей репутации. Кроме того, они могут опорочить ваш бизнес в соответствующей вики-статье.

Из-за этого вы должны следить за своей вики-страницей, а также за другими страницами, на которых упоминается ваш бизнес, как только он будет создан. Вы можете легко сделать это с помощью парсера вики.

Вы можете периодически искать на страницах Википедии упоминания о вашем бизнесе и указывать на любые случаи вандализма.

Повышение SEO

Вы можете использовать Википедию для увеличения посещаемости вашего сайта.

Создайте список статей, которые вы хотели бы изменить, используя парсер данных Wiki, чтобы найти страницы, которые имеют отношение к вашему бизнесу и вашей целевой аудитории.

Начните с прочтения статей и внесения нескольких полезных изменений, чтобы завоевать доверие участников сайта.

После того, как вы добились определенного доверия, вы можете добавить ссылки на свой веб-сайт в местах, где есть неработающие ссылки или где требуются цитаты.

Быстрые ссылки

Библиотеки Python, используемые для парсинга веб-страниц

Как уже было сказано, Python — самый популярный и авторитетный язык программирования и инструмент для веб-скрейпинга в мире. Теперь давайте посмотрим на библиотеки веб-скрейпинга Python, которые доступны прямо сейчас.

Запросы (HTTP для людей) Библиотека для парсинга веб-страниц

Он используется для отправки различных HTTP-запросов, таких как GET и POST. Среди всех библиотек это самая фундаментальная, но и самая важная.

Библиотека lxml для парсинга веб-страниц

Пакет lxml предлагает очень быстрый и высокопроизводительный анализ текста HTML и XML с веб-сайтов. Это тот, который нужно выбрать, если вы собираетесь очищать огромные базы данных.

Библиотека Beautiful Soup для парсинга веб-страниц

Его работа заключается в построении дерева синтаксического анализа для анализа содержимого. Отличное место для начинающих и очень удобно.

Библиотека Selenium для парсинга веб-страниц

Эта библиотека решает проблему, которая есть у всех вышеперечисленных библиотек, а именно очистку контента от динамически заполняемых веб-страниц.

Изначально он был разработан для автоматизированного тестирования веб-приложений. Из-за этого он медленнее и не подходит для задач промышленного уровня.

Scrapy для парсинга веб-страниц

Полноценный фреймворк для парсинга веб-страниц, который использует асинхронное использование это БОСС всех пакетов. Это повышает эффективность и делает его невероятно быстрым.

Заключение

Так что это был самый важный аспект, который вам нужно знать о парсинге веб-страниц из Википедии. Оставайтесь с нами, чтобы узнать больше таких информативных сообщений о веб-скрейпинге и многом другом!

Полезное